ARTÍCULO ORIGINAL

CHAGAS, Edgar Thiago de Oliveira [1]

CHAGAS, Edgar Thiago de Oliveira. Inteligencia artificial, computación cuántica, robótica y Blockchain. ¿Cuál es la realidad de estas tecnologías en los tiempos actuales y futuros?. Revista Científica Multidisciplinar Núcleo do Conhecimento. año 04, Ed. 06, Vol. 09, págs. 72-95. junio de 2019. ISSN: 2448-0959

RESUMEN

En áreas como la inteligencia artificial, es necesario utilizar otros tipos de ordenadores y arquitecturas. Por ejemplo, en algoritmos de reconocimiento de imágenes o procesamiento de voz, la ejecución secuencial y el almacenamiento de la arquitectura de Von Neumann (muy eficaz para otras aplicaciones) se convierte en una limitación que limita el rendimiento de estos sistemas. En esta premisa, el presente trabajo buscó analizar la inteligencia artificial, la computación cuántica, la robótica y la cadena de bloques, para reflexionar sobre la realidad de estas tecnologías en tiempos actuales y futuros.

Palabras clave: Inteligencia artificial, computación cuántica, robótica, Blockchain.

1. INTRODUCCIÓN

Este artículo tiene como objetivo reflexionar sobre conceptos relacionados con la computación clásica y la computación cuántica. De esta manera, el trabajo propone analizar los ordenadores actuales, así como sus limitaciones y percepciones sobre el futuro. Los conceptos básicos de la arquitectura de von Neumann y la computación cuántica se introducirán para dicho análisis. El objetivo es discutir el significado de estos conceptos centrados en la informática. En este sentido, la investigación describe la historia del desarrollo de microprocesadores a partir de una visión general de la computación cuántica. El énfasis se centra en distinguir entre las principales características de la computación tradicional y la computación cuántica. Por último, proponemos una reflexión sobre las principales dificultades técnicas encontradas en la construcción de ordenadores cuánticos, así como en algunas investigaciones en este campo.

2. COMPUTACIÓN CLÁSICA

Hoy en día, las computadoras realizan una variedad de actividades que requieren un tiempo considerable de procesamiento y ejecución. La búsqueda de reducir el tiempo de ejecución de estas actividades llevó a los investigadores a desarrollar máquinas cada vez más rápidamente. Sin embargo, llegará un momento en que los límites físicos impedirán la creación de dispositivos más rápidos. En este contexto, las leyes de la física imponen un límite a la miniaturización de los circuitos. De esta manera, en el futuro, los transistores serán tan pequeños que los componentes de silicio serán casi moleculares en tamaño. A distancias microscópicas, las leyes de la mecánica cuántica tienen un efecto, haciendo que los electrones salten de un punto a otro sin cruzar el espacio entre ellas, causando muchos problemas.

Los ordenadores actuales se basan en la arquitectura de Von Neumann. Era un matemático húngaro de origen judío, pero naturalizado como estadounidense. Von Neumann contribuyó al desarrollo de la teoría conjunta, el análisis funcional, la teoría erodical, la mecánica cuántica, la informática, la economía, la teoría de juegos, el análisis numérico, la hidrodinámica de explosiones, Estadísticas y otras diversas áreas de las matemáticas. Es considerado uno de los matemáticos más importantes del siglo TWENTIETH. Un ordenador basado en la arquitectura de Von Neumann distingue claramente los elementos de procesamiento y almacenamiento de información, es decir, tiene un procesador y una memoria separados por un bus de comunicación. En el ordenador de von Neumann surgieron dos aspectos: la organización de la memoria y el tratamiento.

Las computadoras modernas tienen los mismos estándares que se basan en la arquitectura de Von Neumann. Esta solución divide el hardware del equipo en tres componentes principales: memoria, CPU y dispositivos de entrada y salida. Memory Stores instrucciones y datos del programa; La CPU es responsable de extraer instrucciones y datos de la memoria, ejecutarlos y, a continuación, almacenar los valores obtenidos en la memoria y los dispositivos de entrada (como el teclado, el ratón y el micrófono) y los dispositivos de salida (como monitor, altavoces e impresora) Permitir la interacción del usuario, mostrando, tanto para, datos como para instrucciones relacionadas con el procesamiento de resultados. Las palabras almacenadas en la memoria pueden contener instrucciones y datos. A su vez, el procesamiento es secuencial y puede incluir desviaciones condicionales o incondicionales.

La presencia de contadores de programa (incrementado por cada instrucción) y memoria principal (incluidos los programas ejecutables y sus archivos de datos) refleja estas características. Estas son dos de las características más importantes de la arquitectura von Neumann, ya que no sólo definen el propio ordenador, sino también todo el contenido asociado de algoritmos complejos para resolver algunos de los problemas de eficiencia. Para ilustrar aún más la importancia de estas características de la arquitectura de Von Neumann, considere el siguiente ejemplo. Cuando un programador desarrolla software, escribe un algoritmo (un conjunto de instrucciones) para resolver el problema.

La forma en que la mayoría de los programadores diseñan e implementan esta solución es secuencial, no sólo porque la gente piensa en orden, sino porque los ordenadores construidos y usados hace 50 años funcionan en secuencia. La programación (estructural, lógica o funcional) y el procesamiento secuencial son consecuencias directas de la arquitectura de Von Neumann. Incluso los nuevos paradigmas de programación, como la orientación de objetos, todavía se limitan a estos conceptos. A pesar de algunas limitaciones, esta forma de organizar ordenadores es muy eficaz para la mayoría de las actividades realizadas por los ordenadores modernos. Puede que no haya mejor manera de hacer cálculos matemáticos, editar texto, almacenar datos o acceder a Internet, porque los ordenadores von Neumann son la mejor máquina para estas tareas.

Sin embargo, para áreas específicas de desarrollo, como el cifrado, puede ser necesaria una nueva herramienta informática, así como una nueva estrategia para abordar los problemas y así encontrar soluciones. Los programas de cifrado actualmente funcionan eficazmente porque no son adecuados para la descomposición en grandes cantidades, por lo que poseen más de unos pocos cientos y más que la capacidad de las máquinas más modernas. La dificultad de descomponer una gran cantidad no puede atribuirse únicamente a los materiales. Esto puede deberse a aspectos relacionados con el software y el hardware.

No se puede decir que la tarea de la máquina actual para lograr esta naturaleza es ineficiente porque el equipo actual no tiene suficiente potencia o velocidad de procesamiento. El problema puede ser la falta de conocimiento (o creatividad) en el diseño de los algoritmos necesarios. Por lo tanto, los procesadores actuales pueden incluso ser suficientes para resolver el problema de la descomposición masiva, sin embargo, los seres humanos no entienden cómo implementar el algoritmo. Por otro lado, la falta de un algoritmo de este tipo puede ser el resultado de la falta de un ordenador lo suficientemente potente. La verdad es que la investigación no es decisiva, ya que se desconoce la fuente del problema relacionado con el hardware, el software o ambos.

2.1 AUTOMATIZACIÓN, EL CAMINO HACIA EL MUNDO MODERNO

En el sistema capitalista, la globalización preactúa en los mercados laborales del mundo, por lo que la automatización funciona como base para que las empresas sigan siendo competitivas. Esta es ya la realidad de las industrias, porque la tecnología se ha convertido en un elemento esencial. El tema propuesto también está relacionado con que los puestos de trabajo generados frente a la automatización sean inversamente proporcionales. La automatización es la inversión necesaria para grandes, medianas y pequeñas empresas. Las máquinas obsoletas dificultan la producción y terminan siendo un factor preponderante para la retirada de muchas empresas del mercado. En este contexto, los ordenadores son responsables de agilizar los servicios burocráticos, así como de transmitir información precisa y rápida a las empresas, así como a los robots, así como a acelerar el mercado.

Está claro que la tecnología ha reducido el número de puestos de trabajo, pero ha hecho que los consumidores sean más exigentes, así como una mayor agilidad y competitividad en el comercio. Con esto, los gastos de las empresas disminuyeron y los beneficios aumentaron. La fianza de empleo genera carga para las empresas con impuestos pagados bajo los empleados, siendo las máquinas inversiones de alto costo, pero que cesan o disminuyen los gastos con estos y traen, rápidamente, la rentabilidad del capital invertido. Los trabajadores siempre deben reciclarse y perfeccionarse a sí mismos a través de cursos y formaciones, porque el mercado laboral es cada vez más competitivo, por lo que aquellos que no se reciclan a sí mismos terminan obteniendo el margen de evolución.

Está creciendo, en los países capitalistas, la preocupación por la evolución que se produce en los campos de la biología, de la microelectrónica, entre otros. Destarte, la preocupación llega a la raza modernista, porque hay una rápida superación de las máquinas; Pero también tiene el objetivo de los trabajadores que pierden su trabajo. Es a menudo, en las empresas, el regreso de los antiguos empleados a los bancos escolares. Esto demuestra que las empresas confían en mano de obra calificada y, por lo tanto, ganan dinamismo y calidad para competir.

2.2 AUTOMATIZACIÓN INDUSTRIAL

La historia de la automatización industrial tuvo su oportunidad con la producción de las líneas de montaje de carácter automovilístico. Uno de los ejemplos más expresivos es Henry Ford. Esto ganó espacio en el mercado en la década de 1920. Desde este período, el avance tecnológico ha ganado impulso en las más diversas áreas interconectadas con la automatización, lo que ha tenido un aumento significativo en la calidad y cantidad de producción, priorizando principalmente la reducción de costos. En este contexto, el avance de la automatización, en general, está ligado a la evolución de la microelectrónica, que ha ganado más fuerza y espacio en los últimos años. Un ejemplo de este proceso es la creación del controlador programable Lógico (PLCS).

Esta herramienta surgió en la década de 1960, con el objetivo de sustituir los paneles de la cabina, ya que tenían características más negativas que positivas, principalmente porque ocupaban un espacio físico muy expresivo. Así, desde el momento en que fue necesario realizar cambios en la programación lógica de los procesos realizados por interconexiones eléctricas con lógica fija, se requirió interrupciones en el proceso de producción en detrimento de la necesidad de reconectar la Elementos de control de panel. Esta práctica tomó mucho tiempo, por lo que hubo una gran pérdida en la producción, así como hubo un alto consumo de energía.

En este contexto, en el año 1968, en la división Hidramática de "General Motors Corporation", se llevó a cabo un experimento centrado en el control lógico. Se pretendía que la programación de los recursos vinculados al software estuviera vinculada al uso de dispositivos periféricos, pudiendo realizar operaciones de entrada y salida desde un microordenador con capacidad de programación. Este experimento redujo significativamente los costos de automatización del tiempo. Por lo tanto, con la creación de microprocesadores, ya no era necesario utilizar ordenadores grandes. Por lo tanto, el PLC (nombre dado al experimento), se convirtió en una unidad aislada, recibiendo, para eso, algunos recursos.

Son la interfaz de programación y operación de una manera fácil para el usuario; Instrucciones aritméticas, así como manipulación de datos; Capacidades de comunicación de redes PLC y nuevas posibilidades de configuración específicas para cada propósito a partir de módulos intercambiables. En este sentido, desde una visión más integrada de la planta de la fábrica con el entorno corporativo, todas las decisiones organizativas relacionadas con el sistema de producción comenzaron a tomarse a través de los conceptos votados sobre calidad, basados, En hormigón y datos actuales se originaron a partir de diferentes unidades de control. De esta manera, los fabricantes de CLPs necesitan entender la desigualdad básica: software y hardware para la producción de sistemas SCADA, así como para otros sistemas especializados.

Por lo tanto, los softwares SCADA toman forma de diferentes tamaños y sistemas operativos, así como tienen varias funcionalidades. Para ser presentado como herramientas completas, añadir al SLP para competir. Sin embargo, en el área de la instrumentación, esta revolución tomó más lentamente, porque era necesario equipar los instrumentos de más inteligencia, así como hacer que se comunicaran en una red, es decir, para que el estándar de 4-20 mA pudiera transmitir señales analógicas, debe Dale su lugar a la transmisión digital. Este principio fue desarrollado a partir de un protocolo que se aprovechaba del cableado existente en sí, transitando así las señales digitales en las señales analógicas 4-20 mA. Este protocolo (HART) no era más que un paliativo, aunque permanece hasta hoy en su interinidad.

Este fenómeno también representa una forma de reacción al avance y la existencia de las nuevas tecnologías, porque, después, se crearon un gran número de patrones y protocolos que intentaron mostrarse como únicos y mejores. En un contexto actual, los Plcs se utilizan, sobre todo, para la implementación de paneles de enclavamiento secuenciales, para el control de mallas, para los sistemas de control de celdas de fabricación, entre otros. También se encuentran en procesos relacionados con el envasado, embotellado, enlatado, transporte y manipulación de materiales, mecanizado, con generación de energía, en sistemas de control de edificios de aire acondicionado, en sistemas de Seguridad, montaje automatizado, líneas de pintura y sistemas de tratamiento de agua en las industrias alimentaria, de bebidas, automotriz, química, textil, plásticos, pulpa y papel, farmacéutica, acero y metalúrgica.

3. HISTORIA

En 1965, Gordon Moore, cofundador de Intel, uno de los principales fabricantes de microprocesadores, hizo una predicción que se hizo famosa siendo conocida como la ley de Moore. Según él, el número de transistores de un microprocesador se doblaría a intervalos de tiempo aproximadamente constantes entre uno y tres años. Esto significa un avance exponencial en la evolución del procesamiento de la máquina. En este contexto, se constató que la ley era válida desde entonces hasta la actualidad, período en el que se observó que la potencia de procesamiento se duplicaba, aproximadamente, cada 18 meses.

3.1 LA PROMESA DE LOS PROCESADORES CUÁNTICOS

Los procesadores cuánticos parecen ser el futuro de la computación. La arquitectura actual, incluido el uso de transistores para construir procesadores, inevitablemente alcanzará sus límites dentro de unos pocos años. Entonces será necesario elaborar una arquitectura más eficiente. ¿Por qué no reemplazar el transistor con un átomo? Los procesadores cuánticos tienen el potencial de ser eficientes, y en segundos, los procesadores actuales ni siquiera se pueden completar en millones de años.

3.2. POR QUÉ LOS PROCESADORES CUÁNTICOS

De hecho, el diseñador de microprocesadores hizo un trabajo significativo. En las últimas tres décadas, desde la llegada de Intel 4004, la velocidad de procesamiento del primer microprocesador del mundo ha crecido expresivamente. Para hacerse una idea, el i8088 es el procesador utilizado en el XT lanzado en 79, tiene una capacidad de procesamiento estimada de sólo 0,25 meglops, o sólo 250.000 operaciones por segundo. El Pentium 100 ha procesado 200 operaciones y 200 millones de operaciones, mientras que el Athlon de 1,1 GHz procesa casi 10 gigaflops, 40.000 veces más rápido que el 8088.

El problema es que todos los procesadores actuales tienen una limitación común: consisten en transistores. La solución para producir chips más rápidos es reducir el tamaño de los transistores que los producen. Los primeros transistores aparecieron en la década de 1960, son aproximadamente del tamaño de un cabezal de fósforo, mientras que los transistores actuales son sólo 0,18 micras (1 micra s 0,001 mm). Sin embargo, se ha acercado a los límites físicos de la materia, por lo que para avanzar, tendrá que reemplazar los transistores para estructuras más eficientes. De esta manera, el futuro de los procesadores parece depender de procesadores cuánticos.

3.3. LEY DE MOORE

Uno de los conceptos más conocidos de cálculo es abordado por la llamada ley Moore. A mediados de 1965, Gordon E. Moore, entonces presidente de Intel, predijo que el número de transistores de chip aumentaría en un 60%, al mismo costo, cada 18 meses. Según las predicciones de Moore, la velocidad de las computadoras se duplicaría cada año y medio. Esta ley se ha mantenido desde la publicación del primer PC1 en 1981. El primer microprocesador fabricado por Intel Corporation fue el 4004. Tenía una CPU de 4 bits, con "sólo" 2300 transistores. Su velocidad de funcionamiento era de 400 KHz (kilohercios, no megahercios). La tecnología de fabricación ha alcanzado una densidad de 10 micras. Fabricado en 1971, fue el primer microprocesador en un solo chip, así como el primero disponible en el mercado. Originalmente diseñado para ser un componente de las calculadoras, el 4004 fue utilizado de varias maneras.

Actualmente, el procesador más avanzado de Intel es el Core i7-3960X, con seis núcleos reales y doce segmentos de 3,3 GHz, hasta 3,9 GHz, gracias a la tecnología Turbo Boost. Este procesador tiene 2.27 mil millones de transistores de 22 nanómetros cada uno, mil veces más pequeño que el diámetro de una hebra de cabello; El chip es de silicio. Sin embargo, en algún momento en el futuro, incluso los expertos no saben exactamente cuándo se alcanzará la frontera de silicio y la tecnología no será capaz de avanzar. Por lo tanto, los fabricantes de chips tendrán que migrar a otro material. Este día todavía está lejos, pero los investigadores ya están explorando alternativas. El grafeno recibe mucha atención como un posible sucesor del silicio, pero OPEL Technologies cree que el futuro está en un compuesto llamado arseniuro de galio, también llamado la fórmula molecular GaAs.

Incluso si esta nueva tecnología alcanza sus límites y otra tecnología tiene éxito, eventualmente llegará al límite atómico. A este nivel, es físicamente imposible hacer menos cosas. Esto requiere la realización de un análisis detallado porque conduce a una de las conclusiones más importantes sobre los cálculos numéricos. Desde el advenimiento de la primera computadora digital, no ha habido cambios importantes. Lo que sucedió en los últimos 60 años fue el desarrollo de la tecnología. Han llegado computadoras más pequeñas y rápidas. La válvula se mueve al transistor y finalmente se mueve al microchip. De hecho, este es un ejemplo relacionado con la evolución de la velocidad. Sin embargo, la verdad es que nunca se ha instalado un ordenador más potente.

En este contexto, todos los ordenadores actuales son XT (XT es uno de los primeros ordenadores personales de IBM, equipado con el nombre del chip 8086, el IBM PC original va acompañado de una versión barata del 8088, 8086). TI desarrollado en términos de velocidad, pero no en términos de potencia de computación. Inevitablemente, la tecnología digital alcanzará sus límites tarde o temprano. Desde un punto de vista físico, es imposible aumentar la velocidad del procesador. Esto requerirá cambiar el propio ordenador o descubrir nuevas tecnologías. Para ello, es necesario modificar la arquitectura de Von Neumann. Los cambios arquitectónicos implican la reorganización de los componentes del equipo para mejorar la funcionalidad del dispositivo.

De esta manera, se eliminarán algunas de las limitaciones que implica la arquitectura de Von Neumann. Hoy en día se están estudiando varias soluciones informáticas no convencionales. Algunos incluso implican el uso de moléculas de ADN (ácido desoxirribonucleico). Entre las diversas alternativas a las computadoras digitales en estudio, las más interesantes y prometedoras son las computadoras cuánticas. La siguiente sección de este artículo analiza el desarrollo del conocimiento cuántico en esta área del conocimiento humano, por lo tanto, se describirán los conceptos básicos relacionados con la generación, la evolución, el alcance, las perspectivas futuras y los desafíos inherentes a la computación de carácter cuántico.

4. COMPUTACIÓN QUANTUM

Las computadoras cuánticas funcionan básicamente a partir de reglas relacionadas con la incertidumbre cuántica. Cuando alcanza el nivel de una sola partícula, nada es absoluto (el electrón se puede girar de una manera u otra, pero una mezcla de giros también puede estar presente). En las computadoras cuánticas, la unidad básica de información es bits cuánticos (qubits). Qubits puede tener valores de 0 o 1, así como bits regulares (números binarios). La diferencia es que los qubits pueden tener valores 0 y 1 al mismo tiempo. Es en esta propiedad en particular que hay toda la potencia computacional de las computadoras cuánticas.

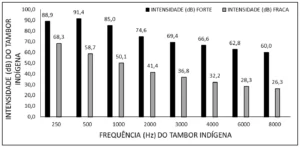

Figura 1: Computación cuántica

La computación cuántica explora las ventajas de la superposición de estado cuántico coherente para lograr el paralelismo cuántico: simultáneamente, logrando la misma operación en diferentes valores qubits. Esto sólo es posible debido a la diferencia fundamental entre qubits (se conocen qubits) y clásicos: Mientras que los bits clásicos pueden ser sólo en el estado 0 o 1, los qubits se pueden superponer en estos estados 0 y 1. Cuando hay dos qubits, los qubits pueden existir como una combinación de todos los dos dígitos posibles. Al añadir un tercer qubit, se pueden combinar los tres números de bits posibles. El sistema ha crecido exponencialmente. Por lo tanto, una colección de qubits puede representar una línea de números y computadoras cuánticas, al mismo tiempo, puede procesar todas las entradas de datos simultáneamente.

El concepto de cálculo cuántico no es tan complejo como la unidad de medida básica es el ordenador clásico. Esto puede tomar los valores 0 o 1 bit. Es esta particularidad la que hace que las estructuras cuánticas sean tan poderosas. El predecesor descrito es el giro cuántico, pero también se propone un autómata para mover la estructura cuántica. La unidad básica de este tipo de computadora se compone de cuatro células cuánticas de puntos cuánticos, por lo que cada unidad tiene dos electrones que buscan permanecer estacionarios. En otras palabras, en el estado que consume menos energía, la fórmula Coulomb indica que la fuerza repulsiva es inversamente proporcional a la distancia del mecanismo de repulsión, por lo que cuanto más cerca esté la fuerza, más probable es repeler. Por lo tanto, tienden a ocupar puntos cuánticos en ambos extremos de la célula, lo que equivale a rotar en una computadora con rotación cuántica. Sin embargo, esta técnica requiere una temperatura de funcionamiento muy baja: 70 mg.

La celda cuántica se utiliza para crear una estructura formada por un cuántico a partir de 5 celdas: Tres celdas de entrada, una "manipulación" de celda y una salida. Esta estructura se denomina entrada de árbol. El funcionamiento de la estructura del filamento en forma básica es el siguiente: La repulsión de electrones mantiene al menos la polarización, de modo que las células tratadas son inducidas para asumir el estado de la mayoría de las unidades de entrada. Por último, la unidad de salida copia el resultado para que la polarización de la unidad no afecte al cálculo de la unidad de procesamiento.

Pero todavía hay algunos problemas, no en términos de arquitectura, sino en el proceso de construcción de computadoras cuánticas, porque una de las razones del error es el propio entorno: el impacto en el medio ambiente puede causar cambios en los qubits, lo que puede causar Incoherencias en el sistema, no válidas. Otra dificultad es que la física cuántica señala que es necesario medir u observar la superposición de los estados de fracaso conductual de un sistema cuántico. Es decir, si lee los datos mientras ejecuta el programa en una computadora cuántica, todo el procesamiento se perderá.

4.1. EL ALGORITHM SHOR

El desarrollo de la computación cuántica comenzó en la década de 1950, cuando se consideraron las leyes de la física y la mecánica cuántica aplicadas a la informática. En 1981, se celebró una reunión en Massachusetts en el Instituto de Tecnología: el MIT discutió este tema. En esta reunión, el físico Richard Feynman propuso el uso de sistemas cuánticos en computadoras, defendiendo que tienen más poder de procesamiento que las computadoras ordinarias. En 1985, David Deutsch, de la Universidad de Oxford, describió la primera computadora cuántica. Es una máquina cuántica de Turing que puede simular otra computadora cuántica. No hubo progresos significativos en la investigación sobre el tema, así que casi una década después, Peter Shaw, un investigador de AT & T, llevó a cabo un estudio de 1994 para desarrollar un algoritmo para factorizar mucho más rápido que las computadoras tradicionales.

El algoritmo utiliza las propiedades de un ordenador cuántico para realizar la descomposición de enteros grandes (aproximadamente 10 200 números) en tiempo polinómico. Este algoritmo, llamado algoritmo Shor, se publica en el artículo "Algoritmos de cálculo cuántico: descomposición de logarithms discretos". El algoritmo utiliza la propiedad de superposición cuántica para reducir la complejidad del problema de tiempo de solución del exponencial al polinomio mediante una función cuántica específica. Comprender las funciones cuánticas utilizadas en el algoritmo Shor requiere una interpretación matemática bastante extensa y compleja que está fuera del alcance de este artículo.

La aplicación directa del algoritmo Shor es aplicable al campo de cifrado. La seguridad de los sistemas criptográficos de clave pública depende de la dificultad de descomponer números muy grandes. La seguridad del sistema de cifrado se ve comprometida por la implementación real de un equipo capaz de realizar estos cálculos rápidamente. La Agencia Espacial de los Estados Unidos (NASA) y Google están invirtiendo en computación cuántica para el futuro de la computación y se están preparando para utilizar las últimas máquinas D-Wave.

4.2 EL COMPUTADOR QUANTUM DE D-WAVE

La nueva versión de D-Wave, computadora cuántica ayudará en la búsqueda de la NASA para el mundo extraterrestre antes de finales de 2013 actúa principalmente para mejorar el servicio. D-Wave TWO Computer-1 512-bit computers- pronto se pondrá en uso en el nuevo Laboratorio de Inteligencia Artificial Cuántica creado por la NASA, Google y USRA (Asociación de Investigación de la Universidad Espacial). El director de ingeniería Harmut Neven Google publicó una nota en el blog de la empresa en la que describía los objetivos de la Organización. Cree que la computación cuántica puede ayudar a resolver problemas de informática en algunos, especialmente en el campo de la inteligencia artificial. La inteligencia artificial se construye a partir de los mejores modelos del mundo para hacer predicciones más precisas.

Para curar la enfermedad, es necesario establecer un modelo más eficaz de enfermedades, así como para desarrollar una política ambiental más eficaz, es necesario desarrollar mejores modelos climáticos globales. Para crear un servicio de búsqueda más útil, debe comprender mejor los problemas y el contenido disponibleen en Internet para obtener la mejor respuesta. Neven, según el comunicado, informa que el nuevo laboratorio transformará estas ideas teóricas en práctica. De esta manera, el trabajo de instalación de la máquina D-Wave comenzó en la NASA en Ames Research Center, campo Moffett en California. La sede central de Google en Mountain View, permaneciendo a pocos minutos.

Esta asociación representa el último avance de D-Wave. El D-Wave es una afirmación, para ambos, fue construido y vendido la primera computadora cuántica comercial del mundo por la compañía canadiense. Muchos laboratorios académicos están trabajando para construir sólo un pequeño número de computadora cuántica qubit, los investigadores involucrados con D-Wave, están trabajando para que la máquina pueda dejar menos dudas. Hace unos años, muchos especialistas en computación cuántica conocidos eran escépticos sobre IEEE Spectrum. En realidad, D-Wave logró conquistar a algunos ex comentaristas. La compañía permite a D-Wave acceder a investigadores independientes. En al menos dos casos, esta apertura ha dado lugar a implicaciones para las acusaciones de computación cuántica y rendimiento corporativo. D-Wave ganó mayor credibilidad cuando comercializó por primera vez Lockheed Martin en 2011.

Según el representante de Google, el nuevo Laboratorio de Inteligencia Artificial Cuántica sometió el nuevo D-Wave Two a rigurosas pruebas antes de que la máquina fuera aprobada. En particular, una prueba requiere que el equipo resuelva algunos problemas de optimización, al menos 10.000 veces más rápido que el equipo clásico. En otro caso, la máquina D-Wave obtuvo la puntuación más alta en la edición estándar del juego SAT. Durante años, Google ha utilizado hardware D-Wave para resolver problemas de aprendizaje automático. La compañía ha desarrollado un algoritmo de aprendizaje automático compacto y eficiente para el reconocimiento de patrones-útil para dispositivos de limitación de potencia como teléfonos inteligentes o tabletas. Otra máquina similar demostró ser muy adecuada cuando, por ejemplo, un alto porcentaje de imágenes en álbumes en línea se ordenó incorrectamente para resolver la "contaminación" de los datos.

La Nasa, por su parte, espera que la tecnología pueda ayudar a acelerar la búsqueda de planetas distantes alrededor del sistema solar, así como apoyar futuros centros de control de misiones espaciales, humanas o robóticas. Los investigadores de la NASA y Google no monopobe el uso de la nueva máquina de laboratorio D-Wave Twono. USRA tiene la intención de proporcionar el sistema a la comunidad de investigación académica estadounidense, una decisión que ayudará a D-Wave a superar a los escépticos. La noticia fue hecha por la aerolínea Lockheed Martin. Así, por US$1.000 millones, a principios de 2013, anunció la compra de la onda D dos poco después, representando la actualización, posteriormente, a la máquina D-Wave One.

4.3 PRUEBA: COMPUTADORA DIGITAL X COMPUTADOR QUANTUM

Por primera vez, una computadora cuántica fue puesta a competir con un PC común-y la computadora cuántica ganó la disputa con Slack. El término computación cuántica siempre está asociado con la idea de "en el futuro", "cuando se convierten en realidad", "si se pueden construir" y cosas por el qué. Esta percepción comenzó a cambiar en 2007, cuando la compañía canadiense D-Wave, presentó una computadora que ella dijo hacer cálculos basados en la mecánica cuántica. El escepticismo entre investigadores y estudiosos del tema fue grande. Sin embargo, en 2011, la comunidad científica tuvo acceso al equipo y podría, además, que el procesador cuántico de D-Wave es realmente cuántico. Ahora, Catherine McGeoch de la Universidad Amherst en los Estados Unidos fue contratada por D-Wave para hacer una comparación entre D-Wave que utiliza "computación cuántica adiabática" y un PC común. Según el investigador, este es el primer estudio que hace una comparación directa entre las dos plataformas informáticas: según ella: "Esta no es la última palabra, sino más bien un comienzo en un intento de averiguar lo que el procesador cuántico puede o no puede hacer."

El procesador cuántico, formado por 439 qubits de bobinas de niobio, fue 3.600 veces más rápido que el PC común en la ejecución de cálculos que implican un problema de optimización combinatoria, que es minimizar la solución de una ecuación eligiendo los valores de ciertas variables. Los cálculos de esta naturaleza son ampliamente utilizados en los algoritmos que hacen el reconocimiento de imágenes, la visión artificial y la inteligencia artificial. La computadora cuántica de D-Wave encontró la mejor solución en medio segundo, aproximadamente, mientras que la computadora clásica más eficiente necesitaba media hora para alcanzar el mismo resultado.

El investigador reconoce que no era un juego completamente limpio, ya que los ordenadores genéricos, por regla general, no lo hacen tan bien contra los procesadores dedicados a resolver un tipo específico de problema. Así, según ella, el siguiente paso de la comparativa será hacer la disputa entre el procesador cuántico adiabático y un procesador clásico desarrollado para este tipo de cálculo, como una GPU utilizada en tarjetas gráficas. El investigador destacó el carácter especializado de la computadora cuántica, señalando que es excelente para realizar cálculos. Afirma que este tipo de ordenador no está destinado a navegar por Internet, sino que resuelve este tipo específico pero importante de problema muy rápido.

4.4 TECHNOLOGIES

Rutas de datos a posibles aplicaciones para el procesamiento de información cuántica, ¿cómo puede ejecutarlas en sistemas físicos reales? En una escala de unos pocos qubits, hay muchas propuestas de trabajo para dispositivos de procesamiento de información cuántica. Tal vez la forma más fácil de llegar a ellos es a partir de técnicas ópticas, es decir, de la radiación electromagnética. Los dispositivos simples, como espejos y divisores de vigas, se pueden utilizar para realizar manipulaciones elementales en fotones. Sin embargo, los investigadores han encontrado que es muy difícil producir fotones separados sucesivamente. Por esta razón, optaron por usar esquemas que producen fotones individuales "de vez en cuando", al azar.

Los experimentos de criptografía cuántica, codificación superdensa y teletransportación cuántica se realizaron utilizando técnicas ópticas. Una ventaja de estas técnicas es que los fotones tienden a ser portadores muy estables de información de la mecánica cuántica. Un inconveniente es que los fotones no interactúan directamente entre sí. La interacción debe ser mediada por otro elemento, a partir de un átomo, ya que introduce complicaciones adicionales que causan ruido al experimento. Una interacción efectiva entre los dos fotones se produce de la siguiente manera: El número de fotones interactúa con el átomo, que, a su vez, interactúa con el segundo fotón, causando una interacción completa entre los dos fotones.

Un esquema alternativo se basa en métodos que capturan diferentes tipos de átomos: existe la trampa de iones, en la que un pequeño número de átomos cargados están atrapados en un espacio confinado; Y las trampas iónicas neutrales se utilizan para capturar átomos sin carga en este espacio confinado. Los esquemas de procesamiento de información cuántica basados en trampas de átomos utilizan átomos para almacenar qubits. La radiación electromagnética también aparece en estos esquemas (pero de manera diferente a la reportada en el enfoque "óptico" del procesamiento de información cuántica). En estos esquemas, los fotones se utilizan para manipular la información almacenada en átomos. Las puertas cuánticas únicas se pueden realizar aplicando pulsos de radiación electromagnética apropiados a átomos individuales.

Los átomos vecinos pueden interactuar entre sí a través, por ejemplo, de fuerzas dipolares que permiten la ejecución de puertas cuánticas. Además, es posible modificar la naturaleza exacta de la interacción entre los átomos vecinos, aplicando pulsos de radiación electromagnética apropiados a los átomos, lo que permite al experimentador determinar los puertos ejecutados en el sistema. Por último, la medición cuántica se puede realizar en estos sistemas utilizando la técnica de salto cuántico, que implementa con precisión mediciones basadas en el cálculo utilizado en el cálculo cuántico. Otra clase de sistemas de procesamiento de información cuántica se basa en la resonancia magnética nuclear, conocida bajo las iniciales del término inglés NMR. Estos esquemas almacenan información cuántica en los giros nucleares de las moléculas atómicas y manipulan esta información con la ayuda de la radiación electromagnética.

El procesamiento de información cuántica por RMN se enfrenta a tres dificultades particulares que hacen que esta tecnología sea diferente de otros sistemas de procesamiento de información cuántica. En primer lugar, las moléculas se preparan dejándolas en equilibrio a temperatura ambiente, que es mucho más alta que las energías de la rotación de giro que los giros se orientan casi completamente al azar. Este hecho hace que el estado inicial sea particularmente "ruidoso" de lo deseable para procesar información cuántica. Un segundo problema es que la clase de mediciones que se pueden utilizar en la RMN no incluye todas las medidas necesarias para realizar el procesamiento de la información cuántica. Sin embargo, en muchos casos de procesamiento de información cuántica, la clase de mediciones permitidas en RMN es suficiente.

En tercer lugar, dado que las moléculas no pueden tratarse individualmente en RMN, es natural imaginar cómo se pueden tratar adecuadamente los qubits individuales. Sin embargo, diferentes núcleos de la molécula pueden tener diversas propiedades que permiten que se acosen individualmente o al menos se procesen a una escala lo suficientemente granular como para permitir las operaciones esenciales de la computación Cuántica. El CENTRO de Investigación de IBM Almaden ha producido excelentes resultados: una máquina cuántica de siete átomos y NRM se construyeron con éxito y ejecutaron correctamente el algoritmo Shor, con Factor 15. Esta computadora utilizó cinco átomos de flúor y dos átomos de carbono.

4.5 PROBLEMAS

La principal dificultad encontrada en la construcción de computadoras cuánticas es la alta incidencia de errores. Una de las razones para definir el error en sí es que la influencia del soporte en la computadora cuántica puede conducir a una variante del qubit. Al deshabilitar todos los cálculos, estos errores pueden causar incoherencias del sistema. Por lo tanto, otra dificultad es el significado de la mecánica cuántica, el principio que hace que las computadoras cuánticas sean tan interesantes. La física cuántica afirma que medir u observar un sistema cuántico puede destruir la superposición de los estados. Esto significa que si el programa está leyendo datos mientras se ejecuta en una computadora cuántica, todo el procesamiento se perderá.

La mayor dificultad es la capacidad de corregir errores sin medir realmente el sistema. Esto se logra mediante la coherencia de la fase. Esta tecnología puede corregir errores sin dañar el sistema. Para ello, la resonancia magnética se utiliza para replicar un solo bit de información cuántica fontrónica de una molécula de tricloroetileno trinuclear. Básicamente, esta técnica utiliza observaciones indirectas para realizar incoherencias y mantener la coherencia del sistema. Dadas todas estas dificultades, la importancia de la experiencia de IBM es obvia: los científicos pueden superar todos estos contratiempos y ponerlos en práctica desde el algoritmo Shore en computadoras cuánticas.

5. BLOCKCHAIN

La cadena de bloques, o "cadena de bloques", es una especie de base de datos descentralizada contenida en software específico que trabaja principalmente para verificar la autenticidad de bitcoins y transacciones, donde se registran todas las actividades Hecho con monedas Bitcoin, por lo que es posible verificar la integridad de la moneda y evitar la falsificación. Básicamente, cuando se realiza una transacción, la información generada en ella se agrega a la cadena de bloques, funcionando como un registro. Cuando una transacción necesita ser verificada, los clientes responsables de verificar escanear el contenido de las transacciones relacionadas con el Bitcoin involucrado, de modo que además de la falsificación, se evita el "doble gasto" de la misma moneda.

Los servidores de marca de tiempo sirven para asegurarse de que una determinada información existe o existe en un tiempo válido, para asegurarse de que, posteriormente, las operaciones que dependen de ella son auténticas. El problema con esta verificación en bitcoins es que no hay un servidor centralizado que pueda hacer estas comprobaciones y asegurar a los clientes la integridad de la información, de modo que esta verificación se hace, se adoptó la técnica de prueba de trabajo. Es una técnica que valida una cierta cantidad de información y puede requerir mucho tiempo de procesamiento para ser validado, dependiendo de su complejidad.

Bitcoin utiliza esta técnica para validar la generación de nuevos bloques, basados en el sistema Hashcash. Por lo tanto, para que un bloque se genere correctamente, una parte de su código se publica en la red, de modo que otros bloques lo validan y acepten, convirtiéndose así en un bloque válido.

6. TIPOS DE PROCESADORES

Debido a la llamada estructura de vacío de nitrógeno, los diamantes fueron influenciados por varios equipos de científicos que construyeron procesadores cuánticos. Ahora, un equipo de investigación internacional ha demostrado que no sólo es posible construir un diamante de computadora cuántica, sino también protegerlo de los resultados. En este contexto, la coherencia es un tipo de ruido o interferencia que perturba la sutil relación entre los qubits. Cuando entra, las partículas están en el punto A y el punto B al mismo tiempo, de repente comienza en el punto A o justo en el punto B. Por lo tanto, otro equipo creó un procesador de estado sólido cuántico utilizando materiales semiconductores. Debido a que los sistemas basados en gas y líquidos representan la gran mayoría de los experimentos de computadoras cuánticas hoy en día, los sólidos de procesador escuántico tienen la ventaja de ser capaces de crecer en números cuánticos sin complicaciones sustanciales.

El diamante cuántico es tan simple como sea posible: tiene dos qubits. A pesar del carbono completo, todos los diamantes contienen impurezas, es decir, átomos que se "pierden" en su estructura atómica. Son estas impurezas las que han despertado interés en los científicos que piensan en el área de la computación cuántica. El primero es el núcleo de nitrógeno, mientras que el segundo es un solo electrón "errante", debido a otro defecto en la estructura del diamante de hecho, la broca es el giro de cada uno. La electrónica funciona mejor como bits que como núcleos porque pueden realizar cálculos más rápidamente. Por otro lado, son las víctimas más frecuentes de coherencia.

6.1 APLICACIONES

A partir de la energía del procesador, este tratamiento sería muy útil para la investigación científica, por lo que, por supuesto, se lanzará en estos superordenadores la aplicación comercial de la realidad virtual y la inteligencia artificial, ya que se convertirá en Una moda de este siglo. El juego realmente puede ser suficiente para contener algunos personajes que interactúan con el juego. Puedes hablar y actuar sobre la base de las acciones del jugador, como un RPG casi en tiempo real. Una sola computadora cuántica puede controlar cientos de estos caracteres en tiempo real. El reconocimiento de sonidos y gestos es trivial. No hay duda de que ha habido progresos expresivos en diversos campos que piensan en la inteligencia artificial.

Con el avance de la investigación, habrá un código de cifrado seguro para el uso de algoritmos inteligentes para encuestas de bases de datos de gran tamaño, así como para la realización de seguimiento de inteligencia artificial casi de inmediato, y sin embargo para el Transferencia de datos de forma rápida. El uso de fibra óptica y terabytes de alta densidad por segundo y los routers de mecánica cuántica pueden procesar esta información. Transformar Internet en un mundo virtual es suficiente, porque en un mundo virtual la gente puede integrarse con los avatares y relacionarse con el habla, los gestos e incluso el tacto, como en el mundo real. Esta será la evolución de los debates en curso. La pregunta más importante es cuándo. Nadie sabe realmente lo rápido que es esta investigación. Puede tomar cien años para ver la aplicación en ejecución o sólo veinte o treinta años.

6.2 CÓMO FUNCIONAN

La primera computadora cuántica se hizo realidad, por ejemplo, IBM lanzó su primer chip cuántico en la 12a sesión de la Universidad de Palo Alto este año. Sigue siendo un proyecto muy básico con sólo cinco qubits, sólo 215 Hz, así como requiere muchos equipos para trabajar, sin embargo, se ha demostrado que es un procesador cuántico que es actualmente posible. La primera pregunta de este experimento es cómo mantener esta molécula estable. La solución actualmente en uso es almacenarlo en una solución de refrigeración a alta temperatura cerca de cero absoluto. Sin embargo, este sistema es muy caro. Para ser comercialmente viables, deben superar esta limitación mediante la creación de procesadores cuánticos que pueden funcionar a temperatura ambiente.

El segundo problema es cómo manipular los átomos que componen el procesador. Un átomo puede cambiar de estado a una velocidad alarmante, pero un átomo no puede adivinar el estado que quiere tomar. Para manipular átomos, utilice partículas más pequeñas. La solución descubierta por los diseñadores de IBM es utilizar la radiación en un sistema similar a la resonancia magnética, pero con mayor precisión. Este sistema tiene dos problemas, el primero es el hecho de que es muy caro: un dispositivo, como una hoja, no es menos de US $5 millones. El segundo problema es que la técnica es muy lenta, lo que demuestra el hecho de que el prototipo de la rueda IBM es sólo 215 Hz, millones de veces más rápido que cualquier procesador actual, que ya está en la caja de Gigahertz. Otro obstáculo que Quantum tiene que superar es la viabilidad comercial.

6.3 NUEVOS HOPES

Como se ha reiterado, los procesadores cuánticos experimentales desarrollados hasta ahora son lentos, ya que cuentan con tecnologías emergentes normales, así como requieren equipos complejos y costosos. No es tan fácil de empaquetar como los procesadores Intel o AMD y trabajar a temperatura ambiente, apoyado por un simple enfriador. El prototipo cuántico actual utiliza el dispositivo NMR para manipular el estado de los átomos y moléculas para permanecer estable a temperaturas cercanas al cero absoluto. Aunque ayuda a los científicos a estudiar la mecánica cuántica, estos sistemas nunca son económicamente viables. Hoy en día, el desarrollo de procesadores cuánticos está ganando impulso. El primer experimento buscó demostrar que es una manipulación electrónica muy problemática porque los electrones, debido a su baja calidad y exposición, son muy sensibles a cualquier influencia externa.

Luego manipulan el núcleo, lo que simplifica en gran medida el proceso, porque el núcleo es más alto y la idea está relativamente aislada del entorno externo a través de la barrera de electrones a su alrededor. Pero eso es sólo parte de la solución. De cualquier manera, todavía necesitas desarrollar una técnica para manipular el núcleo. El primer grupo utiliza la RMN, un prototipo técnico muy caro, pero ya hay personas que están desarrollando una manera más fácil de hacerlo. Científicos del Laboratorio Nacional de Los Alamos en los Estados Unidos han publicado experimentos utilizando óptica para manipular protones. La idea de esta nueva tecnología es que los protones se pueden utilizar en forma de formas de onda (que interactúan con los átomos que componen el sistema cuántico) y pueden ser transportados a través de un sistema óptico.

Con esta nueva tecnología, los protones tienen la función de manipular los átomos que componen el procesador cuántico. Debido a que es una partícula, un protón puede ser "lanzado" contra un qubit, alterando su movimiento e impacto. Del mismo modo, los protones pueden ser emitidos para saltar a los qubits. Por lo tanto, la trayectoria del protón se altera. El gran balcón se puede utilizar para recuperar este protón utilizando un fotodetector que detecta protones en la forma de onda, no partículas. Calculando la trayectoria del protón, los datos registrados en los bits se pueden recuperar.

Un problema encontrado durante el experimento fue que había muchos errores en el sistema. Para ello, los investigadores están trabajando en algoritmos de corrección de errores que harán que el sistema sea confiable. Después de todo este trabajo, la computadora cuántica probablemente se volverá más viable de lo esperado. Hace quince años, las computadoras cuánticas eran consideradas sólo ciencia ficción. Hoy en día, algunos prototipos ya están en funcionamiento. La pregunta ahora es ¿cuándo son viables estos sistemas? El progreso que vemos puede ser la respuesta.

CONCLUSIÓN

Para realizar la mayoría de los cálculos matemáticos, editar texto o navegar por Internet, la mejor solución es utilizar el equipo más cercano (basado en la arquitectura Von Neumann). De hecho, los procesadores de hoy en día son muy eficaces en la realización de estas tareas. Sin embargo, en áreas como la inteligencia artificial, es necesario utilizar otros tipos de computadoras y arquitecturas. Por ejemplo, en algoritmos de reconocimiento de imágenes o procesamiento de voz, la ejecución secuencial y el almacenamiento de la arquitectura de Von Neumann (muy eficaz para otras aplicaciones) se convierte en una limitación que limita el rendimiento de estos sistemas.

Para este tipo de aplicación, es más interesante tener un ordenador con capacidad de procesamiento suficiente para coincidir para identificar el formulario (el principio común de resolver estos problemas). Entre las diferentes alternativas, las computadoras cuánticas son las más prometedoras, precisamente porque la computación cuántica difiere de la estructura de von Neumann al tener una enorme potencia de procesamiento paralelo.

Por lo tanto, se puede concluir que las computadoras cuánticas se utilizarán para abordar eficazmente los problemas resueltos por los ordenadores clásicos. El cálculo cuántico se aplicará a problemas en los que no se haya encontrado una solución eficaz, como la inteligencia artificial y el cifrado. El cálculo cuántico puede resolver completamente los problemas extremadamente complejos de la computación clásica. Sin embargo, la dificultad de gestionar estos fenómenos y principalmente la implementación de la arquitectura evolutiva deja mucha incertidumbre para el éxito de estas máquinas. Grandes empresas como IBM están invirtiendo en investigación en esta área y ya están creando los primeros prototipos. Algoritmos para resolver este nuevo paradigma ya están en desarrollo e incluso desarrollando lenguajes de programación.

Queda por saber si el problema se puede resolver, si se trata de un problema de inversión y tiempo o si hay un límite físico que impide la creación de una máquina que pueda superar la máquina actual. Si esto es posible, puede haber un coprocesador cuántico que, junto con el procesador de silicio, constituye un futuro ordenador que puede predecir con mayor precisión el tiempo y refinar el complejo.

REFERENCIAS BIBLIOGRÁFICAS

ACM Computing Surveys, v. 32, n. 3, p. 300-335, 2000.

BECKET, P J. A. Para a arquitetura dos nanomateriais. In: 7ª Conferência Ásia-Pacífico sobre Arquitetura de Sistemas de Computação, Melbourne, Austrália – Conferência sobre Pesquisa e Prática em Tecnologia da Informação, 2002.

BONSOR, K; STRICKLAND, J. Como funcionam os computadores quânticos. Disponível em: http://informatica.hsw.uol.com.br/computadores-quanticos2.htm. Acesso em: 9 mai 2019.

CHACOS, B. Além da Lei de Moore: Como Fabricantes Estão Levando os Chips ao Próximo Nível. Disponível em http://pcworld.uol.com.br/noticias/2013/04/17/alem-da-lei-de-moore-como-fabricantes-estao-levando-os-chips-ao-proximo-nivel/. Acesso em: 10 mai 2019.

FREIVALDS, R. Como simular um livre arbítrio em um dispositivo de computação? AMC, 1999.

GERSHENFELD, N; WEST, J. O computador quântico. Scientific America, 2000.

HSU, J. Google e NASA estarão usando um novo computador D-Wave. Disponível em http://itweb.com.br/107695/google-e-nasa-to-use-new-d-wave/computer. Acesso em: 10 mai 2019.

KNILL, E. Quantum aleatório e não determinístico. Laboratório Nacional Los Alamos, 1996.

MELO, B. L. M; CHRISTOFOLETTI, T. V. D. Computação Quântica – Estado da arte. Disponível em http://www.inf.ufsc.br/~barreto/trabaluno/TCBrunoTulio.pdf . Acesso em: 10 mai 2019.

NAUVAX, P. Arquiteturas de computador especiais. Disponível em http://www.dct.ufms.br/~marco/cquantica/cquantica.pdf . Acesso em: 10 mai 2019.

NIEMIER, M.T; KOGGE, P. M. Exploração e exploração de dutos de nível de cabo Tecnologias emergentes. IEEE, 2001.

RESENDED, A. M. P; JÚNIOR, A. T. da. C. Projeto de Pesquisa PIBIC/CNPq. Disponível em http://www.ic.unicamp.br/~rocha/sci/qc/src/corpoProjeto.pdf . Acesso em: 11 mai 2019.

RIEFFEL, E; WOLFGANG, P. Introdução à computação quântica para não-físicos.

SARKAR, P. Uma breve história de autômatos celulares. ACM Computing Surveys, v. 32, n. 1, 2000.

SKADRON, K. O Papel da Arquitetura de Processador em Ciência da Computação. Comitê sobre os Fundamentos da Computação. Academia Nacional de Ciências, 2001.

WIKILIVROS. Breve introdução à computação quântica. Disponível em http://wikibooks.org/wiki/Breed_introduction_quantum_computation/Print . Acesso em: 10 mai 2019.

[1] Bachelor of Business Administration.

Enviado: Mayo de 2019.

Aprobado: Junio de 2019.