ORIGINAL-ARTIKEL

CHAGAS, Edgar Thiago de Oliveira [1]

CHAGAS, Edgar Thiago de Oliveira. Künstliche Intelligenz, Quantenberechnung, Robotik und Blockchain. Was ist die Realität dieser Technologien in aktuellen und zukünftigen Zeiten?. Revista Científica Multidisciplinar Núcleo do Conhecimento. 04-Jahr, Ed. 06, Band 09, S. 72-95. Juni 2019. ISSN: 2448-0959

ZUSAMMENFASSUNG

In Bereichen wie künstlicher Intelligenz ist es notwendig, andere Arten von Computern und Architekturen zu verwenden. Bei Bilderkennungs- oder Sprachverarbeitungsalgorithmen wird beispielsweise die sequenzielle Ausführung und Speicherung der Von Neumann-Architektur (sehr effektiv für andere Anwendungen) zu einer Einschränkung, die die Leistung dieser Systeme einschränkt. Unter dieser Prämisse versuchte die vorliegende Arbeit, die künstliche Intelligenz, Quantenberechnung, Robotik und Blockchain zu analysieren, um über die Realität dieser Technologien in aktuellen und zukünftigen Zeiten nachzudenken.

Schlüsselwörter: Künstliche Intelligenz, Quantenberechnung, Robotik, Blockchain.

1. EINFÜHRUNG

Dieser Artikel soll über Konzepte im Zusammenhang mit klassischer Berechnung und Quantenberechnung nachdenken. Auf diese Weise schlägt die Arbeit vor, die aktuellen Computer sowie ihre Grenzen und Wahrnehmungen über die Zukunft zu analysieren. Für diese Analyse werden die Grundkonzepte der von Neumann-Architektur und Quantenberechnung vorgestellt. Ziel ist es, die Bedeutung dieser auf Informatik fokussierten Konzepte zu diskutieren. In diesem Sinne beschreibt die Forschung die Geschichte der Entwicklung von Mikroprozessoren aus einem Überblick über die Quantenberechnung. Der Schwerpunkt liegt auf der Unterscheidung zwischen den Hauptmerkmalen der traditionellen Datenverarbeitung und quantenberechnungen. Schließlich schlagen wir eine Reflexion über die wichtigsten technischen Schwierigkeiten vor, die beim Bau von Quantencomputern sowie bei einigen Forschungen auf diesem Gebiet aufgetreten sind.

2. KLASSISCHES COMPUTING

Heute führen Computer eine Vielzahl von Aktivitäten aus, die eine beträchtliche Verarbeitungs- und Ausführungszeit erfordern. Die Suche nach einer Verkürzung der Ausführungszeit dieser Aktivitäten veranlasste die Forscher, Maschinen immer schneller zu entwickeln. Es wird jedoch eine Zeit kommen, in der physische Grenzen die Erstellung schnellerer Geräte verhindern. In diesem Zusammenhang setzen die Gesetze der Physik der Miniaturisierung von Schaltkreisen eine Grenze. Auf diese Weise werden die Transistoren in Zukunft so klein sein, dass die Siliziumkomponenten fast molekular groß sein werden. In mikroskopischen Entfernungen wirken die Gesetze der Quantenmechanik, wodurch Elektronen von einem Punkt zum anderen springen, ohne den Raum zwischen ihnen zu überschreiten, was viele Probleme verursacht.

Aktuelle Computer basieren auf der Architektur von Neumann. Er war ein ungarischer Mathematiker jüdischer Herkunft, wurde aber als Amerikaner eingebürgert. Von Neumann trug zur Entwicklung von Gelenktheorie, Funktionsanalyse, Erodic-Theorie, Quantenmechanik, Informatik, Ökonomie, Spieltheorie, numerische Analyse, Hydrodynamik von Explosionen, Statistiken und andere bereiche der Mathematik. Er gilt als einer der wichtigsten Mathematiker des TWENTIETH Jahrhunderts. Ein Computer, der auf der Von-Neumann-Architektur basiert, unterscheidet die Informationsverarbeitungs- und Speicherelemente deutlich, d.h. er verfügt über einen Prozessor und einen durch einen Kommunikationsbus getrennten Speicher. In von Neumanns Computer tauchten zwei Aspekte auf: die Organisation von Gedächtnis und Behandlung.

Moderne Computer haben die gleichen Standards wie auf der Architektur von Neumanns. Diese Lösung unterteilt die Computerhardware in drei Hauptkomponenten: Arbeitsspeicher, CPU sowie Ein- und Ausgabegeräte. Speicherspeichert Programmanweisungen und Daten; Die CPU ist verantwortlich für das Extrahieren von Anweisungen und Daten aus dem Speicher, deren Ausführung und anschließendes Speichern der in Speicher- und Eingabegeräten (z. B. Tastatur, Maus und Mikrofon) und Ausgabegeräten (z. B. Monitor, Lautsprecher und Drucker) erhaltenen Werte. Erlauben Sie Benutzerinteraktionen, Anzeige von Daten und Anweisungen im Zusammenhang mit der Verarbeitung von Ergebnissen. Im Speicher gespeicherte Wörter können Anweisungen und Daten enthalten. Die Verarbeitung ist wiederum sequenziell und kann bedingte oder bedingungslose Abweichungen umfassen.

Das Vorhandensein von Programmzählern (inkrementiert durch jede Anweisung) und Hauptspeicher (einschließlich ausführbarer Programme und deren Datendateien) spiegelt diese Eigenschaften wider. Dies sind zwei der wichtigsten Merkmale der Von-Neumann-Architektur, da sie nicht nur den Computer selbst definieren, sondern auch alle zugehörigen Inhalte aus komplexen Algorithmen, um einige der Effizienzprobleme zu lösen. Um die Bedeutung dieser Merkmale der Architektur von Neumanns weiter zu veranschaulichen, betrachten Sie das folgende Beispiel. Wenn ein Programmierer Software entwickelt, schreibt er einen Algorithmus (eine Reihe von Anweisungen), um das Problem zu lösen.

Die meisten Programmierer entwerfen und implementieren diese Lösung sequenziell, nicht nur, weil die Leute in ordnung denken, sondern weil Computer, die vor 50 Jahren gebaut und verwendet wurden, nacheinander arbeiten. Programmierung (strukturell, logisch oder funktional) und sequentielle Verarbeitung sind direkte Folgen der Architektur von Neumann. Auch neue Programmierparadigmen, wie z.B. Objektorientierung, beschränken sich noch auf diese Konzepte. Trotz einiger Einschränkungen ist diese Art der Computerorganisation für die meisten Aktivitäten, die von modernen Computern ausgeführt werden, sehr effektiv. Es gibt möglicherweise keine bessere Möglichkeit, mathematische Berechnungen durchzuführen, Text zu bearbeiten, Daten zu speichern oder auf das Internet zuzugreifen, da von Neumann-Computer die beste Maschine für diese Aufgaben sind.

Für bestimmte Entwicklungsbereiche, wie z. B. Verschlüsselung, kann jedoch ein neues Computertool sowie eine neue Strategie zur Lösung von Problemen und damit zur Lösungsfindung erforderlich sein. Die Verschlüsselungsprogramme funktionieren derzeit effektiv, weil sie nicht für die Zersetzung in großen Mengen geeignet sind und somit mehr als ein paar hundert und mehr als die Kapazität der modernsten Maschinen besitzen. Die Schwierigkeit, eine große Menge zu zersetzen, kann nicht nur auf Materialien zurückgeführt werden. Dies kann durch Aspekte im Zusammenhang mit Software und Hardware verursacht werden.

Es kann nicht gesagt werden, dass die Aufgabe der aktuellen Maschine, diese Art zu erfüllen, ineffizient ist, da der aktuelle Computer nicht über ausreichende Leistung oder Verarbeitungsgeschwindigkeit verfügt. Das Problem kann der Mangel an Wissen (oder Kreativität) in der Gestaltung der notwendigen Algorithmen sein. Daher können aktuelle Prozessoren sogar ausreichen, um das Problem der massiven Zersetzung zu lösen, aber der Mensch versteht nicht, wie man den Algorithmus implementiert. Auf der anderen Seite kann das Fehlen eines solchen Algorithmus das Ergebnis eines Mangels an einem ausreichend leistungsfähigen Computer sein. Die Wahrheit ist, dass Forschung nicht entscheidend ist, da die Ursache des Problems im Zusammenhang mit Hardware, Software oder beidem unbekannt ist.

2.1 AUTOMATISIERUNG, DER WEG IN DIE MODERNE WELT

Im kapitalistischen System ist die Globalisierung auf den Arbeitsmärkten der Welt vorprogrammiert, so dass die Automatisierung als Grundlage für Unternehmen dient, um wettbewerbsfähig zu bleiben. Das ist bereits die Realität der Industrien, denn die Technologie ist zu einem wesentlichen Element geworden. Das vorgeschlagene Thema bezieht sich auch auf die Arbeitsplätze, die angesichts der umgekehrtproportionalen Automatisierung entstehen. Automatisierung ist die notwendige Investition für große, mittlere und kleine Unternehmen. Veraltete Maschinen behindern die Produktion und sind am Ende ein vorherrschender Faktor für den Rückzug vieler Unternehmen vom Markt. In diesem Zusammenhang sind Computer für die Rationalisierung bürokratischer Dienstleistungen sowie für die Übermittlung präziser und schneller Informationen an Unternehmen sowie Roboter verantwortlich, die auch den Markt beschleunigen.

Es ist klar, dass die Technologie die Zahl der Arbeitsplätze verringert hat, aber die Verbraucher anspruchsvoller gemacht hat, sowie die Agilität und Wettbewerbsfähigkeit im Handel erhöht hat. Damit gingen die Aufwendungen der Unternehmen zurück und die Gewinne stiegen. Die Beschäftigungsanleihe verursacht Belastungen für Unternehmen mit Steuern, die unter den Arbeitnehmern bezahlt werden, da es sich um Maschineninvestitionen mit hohen Kosten handelt, die aber die Ausgaben damit einstellen oder verringern und schnell die Rendite des investierten Kapitals bringen. Arbeitnehmer sollten immer durch Kurse und Schulungen recyceln und sich selbst perfektionieren, denn der Arbeitsmarkt wird immer wettbewerbsfähiger, so dass diejenigen, die sich nicht selbst recyceln, am Ende die Marge der Evolution bekommen.

Sie wächst in den kapitalistischen Ländern die Sorge um die Entwicklung, die unter anderem in den Bereichen Biologie, Mikroelektronik, stattfindet. Destarte, die Sorge erreicht die modernistische Rasse, weil es eine schnelle Überwindung der Maschinen; Aber es hat auch das Ziel der Arbeiter, die ihre Arbeit verlieren. In Unternehmen ist es oft die Rückkehr alter Mitarbeiter zu Schulbanken. Dies zeigt, dass Unternehmen auf qualifizierte Arbeitskräfte setzen und so Andynamik und Qualität gewinnen, um im Wettbewerb zu bestehen.

2.2 INDUSTRIELLE AUTOMATISIERUNG

Die Geschichte der industriellen Automatisierung hatte ihre Chance mit der Herstellung der Fließbeinen von automobilem Charakter. Eines der ausdrucksstärksten Beispiele ist Henry Ford. Dies gewann Platz auf dem Markt im Jahrzehnt des Jahres 1920. Seit dieser Zeit hat der technologische Fortschritt in den unterschiedlichsten Bereichen, die mit der Automatisierung verbunden sind, an Dynamik gewonnen, was zu einer deutlichen Steigerung der Qualität und Quantität der Produktion führt, wobei vor allem der Kostensenkung Priorität einzuräumen ist. In diesem Zusammenhang hängt die Weiterentwicklung der Automatisierung im Allgemeinen mit der Entwicklung der Mikroelektronik zusammen, die in den letzten Jahren an Stärke und Raum gewonnen hat. Ein Beispiel für diesen Prozess ist die Erstellung des Programmable Logic Controllers (PLCS).

Dieses Werkzeug entstand im Jahrzehnt des Jahres 1960 mit dem Ziel, die Kabinenpaneele zu ersetzen, da sie mehr negative als positive Eigenschaften hatten, vor allem, weil sie einen sehr ausdrucksstarken physischen Raum einnahmen. So war es von dem Moment an, in dem es notwendig war, Änderungen in der logischen Programmierung der Prozesse durch elektrische Verbindungen mit fester Logik durchzuführen, es waren Unterbrechungen im Produktionsprozess erforderlich, zum Nachteil der Notwendigkeit, die Bedienfeld-Steuerelemente. Diese Praxis dauerte lange, so gab es einen enormen Verlust in der Produktion sowie gab es einen hohen Energieverbrauch.

In diesem Zusammenhang wurde im Jahr 1968 in der Hidramatic Division der "General Motors Corporation" ein Experiment durchgeführt, das sich auf die Logikkontrolle konzentrierte. Es war beabsichtigt, dass die Programmierung von Ressourcen, die mit der Software verbunden sind, mit der Verwendung von Peripheriegeräten verbunden war, um Ein- und Ausgabevorgänge von einem Mikrocomputer mit Programmierkapazität durchführen zu können. Dieses Experiment reduzierte die Automatisierungskosten der Zeit erheblich. So war es bei der Erstellung von Mikroprozessoren nicht mehr notwendig, große Computer zu verwenden. So wurde die SPS (Name des Experiments genannt), zu einer isolierten Einheit, die dafür einige Ressourcen erhielt.

Sie sind die Schnittstelle von Programmierung und Bedienung auf einfache Weise für den Benutzer; Arithmetische Anweisungen sowie Datenmanipulation; Kommunikationsmöglichkeiten aus SPS-Netzwerken und neue, für jeden Zweck spezifische Konfigurationsmöglichkeiten aus austauschbaren Modulen. In diesem Sinne begannen alle organisatorischen Entscheidungen im Zusammenhang mit dem Produktionssystem aus einer stärker integrierten Sicht der Fabrikhalle auf das Unternehmensumfeld durch die qualitätsorientierten, In konkreten und aktuellen Daten stammten von verschiedenen Steuergeräten. Auf diese Weise müssen die Hersteller von CLPs die grundlegende Ungleichheit verstehen: Software und Hardware für die Produktion von SCADA-Systemen sowie für andere spezialisierte Systeme.

So nehmen SCADA-Software aus verschiedenen Größen und Betriebssystemen Gestalt an und haben mehrere Funktionalitäten. Um als vollständige Tools präsentiert zu werden, fügen Sie die SLP hinzu, um im Wettbewerb zu bestehen. Im Bereich der Instrumentierung nahm diese Revolution jedoch langsamer an, weil es notwendig war, die Instrumente mit mehr Intelligenz auszustatten und sie in einem Netzwerk kommunizieren zu lassen, d.g., damit die Standard-4-20 mA analoge Signale übertragen konnte, sollte Geben Sie der digitalen Übertragung ihren Platz. Dieses Prinzip wurde aus einem Protokoll entwickelt, das die vorhandene Verdrahtung selbst nutzte und so digitale Signale auf die analogen Signale 4-20 mA übertrug. Dieses Protokoll (HART) war nicht mehr als ein Linderungsmittel, obwohl es bis heute in seiner Interinität bleibt.

Dieses Phänomen stellt auch eine Form der Reaktion auf den Fortschritt und die Existenz neuer Technologien dar, da danach eine Vielzahl von Mustern und Protokollen geschaffen wurden, die versuchten, sich als einzigartig und besser zu zeigen. In einem aktuellen Kontext werden die Spsvorb vor allem für die Implementierung von sequentiellen Verriegelungsplatten, zur Steuerung von Netzen, unter anderem für die Fertigungszellensteuerung enthoben. Sie finden sich auch in Prozessen im Zusammenhang mit Verpackung, Abfüllung, Kartonierung, Transport und Handhabung von Materialien, Bearbeitung, mit Derstromerzeugung, in Gebäudesteuerungssystemen der Klimaanlage, in Systemen der Sicherheit, automatisierte Montage, Lackieranlagen und Wasseraufbereitungsanlagen in der Lebensmittel-, Getränke-, Automobil-, Chemie-, Textil-, Kunststoff-, Zellstoff- und Papierindustrie, Pharma-, Stahl- und Hüttenindustrie.

3. GESCHICHTE

1965 machte Gordon Moore, Mitbegründer von Intel, einem der führenden Hersteller von Mikroprozessoren, eine Vorhersage, die als Moores Gesetz bekannt wurde. Ihm zufolge würde sich die Anzahl der Transistoren eines Mikroprozessors in etwa konstanten Zeitintervallen zwischen einem und drei Jahren biegen. Dies bedeutet einen exponentiellen Fortschritt in der Entwicklung der Maschinenverarbeitung. In diesem Zusammenhang wurde festgestellt, dass das Gesetz von da an bis heute gültig war, in dem festgestellt wurde, dass sich die Verarbeitungsleistung etwa alle 18 Monate verdoppelte.

3.1 DAS PROMISE VON QUANTUM PROCESSORS

Quantenprozessoren scheinen die Zukunft des Rechnens zu sein. Die derzeitige Architektur, einschließlich des Einsatzes von Transistoren zum Bau von Prozessoren, wird unweigerlich in wenigen Jahren an ihre Grenzen stoßen. Dann wird es notwendig sein, eine effizientere Architektur zu erarbeiten. Warum nicht den Transistor durch ein Atom ersetzen? Quantenprozessoren haben das Potenzial, effizient zu sein, und in Sekundenschnelle können aktuelle Prozessoren nicht einmal in Millionen von Jahren fertiggestellt werden.

3.2. WARUM QUANTUM PROCESSORS

Tatsächlich hat der Mikroprozessor-Designer einen bedeutenden Job gemacht. In den letzten drei Jahrzehnten, seit dem Aufkommen von Intel 4004, ist die Verarbeitungsgeschwindigkeit des weltweit ersten Mikroprozessors ausdrucksstark gestiegen. Um eine Idee zu bekommen, ist der i8088 der Prozessor, der in der XT in 79 veröffentlicht verwendet wird, es hat eine geschätzte Verarbeitungskapazität von nur 0,25 meglops, oder nur 250.000 Operationen pro Sekunde. Der Pentium 100 hat 200 Meglops und 200 Millionen Operationen verarbeitet, während der 1,1 GHz Athlon fast 10 Gigaflops verarbeitet, 40.000 Mal schneller als der 8088.

Das Problem ist, dass alle aktuellen Prozessoren eine gemeinsame Einschränkung haben: Sie bestehen aus Transistoren. Die Lösung, schnellere Chips zu produzieren, besteht darin, die Größe der Transistoren zu reduzieren, die sie herstellen. Die ersten Transistoren, die im Jahrzehnt 1960 erschienen sind, sind ungefähr so groß wie ein Phosphorkopf, während die aktuellen Transistoren nur 0,18 Mikrometer (1 Mikron = 0,001 mm) betragen. Es hat sich jedoch den physischen Grenzen der Materie genähert, so dass Sie, um vorwärts zu kommen, die Transistoren durch effizientere Strukturen ersetzen müssen. Auf diese Weise scheint die Zukunft der Prozessoren von Quantenprozessoren abhängig zu sein.

3.3. MOORE'S LAW

Eines der bekanntesten Konzepte der Berechnung wird durch das sogenannte Moore-Gesetz angegangen. Mitte 1965 prognostizierte Gordon E. Moore, damals Präsident von Intel, dass die Zahl der Chiptransistoren alle 18 Monate um 60 % zu gleichen Kosten steigen würde. Nach Moores Vorhersagen würde sich die Geschwindigkeit von Computern jedes Jahr und die Hälfte verdoppeln. Dieses Gesetz wird seit der Veröffentlichung des ersten PC1 im Jahr 1981 beibehalten. Der erste Mikroprozessor der Intel Corporation war der 4004. Es hatte eine 4-Bit-CPU, mit "nur" 2300 Transistoren. Seine Betriebsgeschwindigkeit betrug 400 KHz (Kilohertz, nicht Megahertz). Die Fertigungstechnologie hat eine Dichte von 10 Mikrometern erreicht. Hergestellt 1971, war es der erste Mikroprozessor in einem einzigen Chip, sowie der erste auf dem Markt. Ursprünglich als Bestandteil von Rechnern konzipiert, wurde der 4004 auf verschiedene Weise verwendet.

Derzeit ist Intels fortschrittlichster Prozessor der Core i7-3960X mit sechs echten Kernen und zwölf 3,3 GHz Segmenten bis zu 3,9 GHz dank Turbo Boost-Technologie. Dieser Prozessor hat 2,27 Milliarden Transistoren von je 22 Nanometern, tausendmal kleiner als der Durchmesser einer Haarsträhne; Der Chip ist Silizium. Irgendwann in der Zukunft wissen die Experten jedoch nicht genau, wann die Siliziumgrenze erreicht wird und die Technologie nicht weiterkommen wird. Daher müssen Chiphersteller auf ein anderes Material umstellen. Dieser Tag ist noch weit weg, aber die Forscher erforschen bereits Alternativen. Graphen erhält viel Aufmerksamkeit als potenzieller Nachfolger von Silizium, aber OPEL Technologies glaubt, dass die Zukunft in einer Verbindung namens Galliumarsenid liegt, auch als Molekularformel GaAs bezeichnet.

Selbst wenn diese neue Technologie an ihre Grenzen stößt und eine andere Technologie erfolgreich ist, wird sie schließlich die atomare Grenze erreichen. Auf dieser Ebene ist es physisch unmöglich, weniger Dinge zu tun. Dies erfordert die Realisierung einer detaillierten Analyse, da sie zu einer der wichtigsten Schlussfolgerungen über numerische Berechnungen führt. Seit dem Aufkommen des ersten digitalen Computers hat es keine größeren Veränderungen gegeben. Was in den letzten 60 Jahren geschah, war die Entwicklung der Technologie. Kleinere, schnellere Computer sind angekommen. Das Ventil bewegt sich zum Transistor und schließlich zum Mikrochip. In der Tat ist dies ein Beispiel für die Entwicklung der Geschwindigkeit. Die Wahrheit ist jedoch, dass ein leistungsfähigerer Computer noch nie installiert wurde.

In diesem Zusammenhang sind alle aktuellen Computer XT (XT ist einer der ersten PCs von IBM, ausgestattet mit dem Namen des 8086-Chips, der ursprüngliche IBM PC wird von einer billigen Version des 8088, 8086 begleitet). Die IT entwickelte sich in Bezug auf geschwindigkeit, aber nicht in Bezug auf rechenmäßige Leistung. Unweigerlich stößt die digitale Technologie früher oder später an ihre Grenzen. Aus physikalischer Sicht ist es unmöglich, die Geschwindigkeit des Prozessors zu erhöhen. Dazu müssen Sie den Computer selbst ändern oder neue Technologien entdecken. Zu diesem Zweck ist es notwendig, die Architektur von Neumann zu ändern. Architekturänderungen umfassen die Neuorganisation von Computerkomponenten, um die Gerätefunktionalität zu verbessern.

Auf diese Weise werden einige der Einschränkungen, die von Von Neumanns Architektur impliziert werden, beseitigt. Mehrere unkonventionelle Computerlösungen werden heute untersucht. Einige beinhalten sogar die Verwendung von DNA-Molekülen (Desoxyribonukleinsäure). Unter den verschiedenen Alternativen zu den untersuchten digitalen Computern sind die Quantencomputer die interessantesten und vielversprechendsten. Der nächste Abschnitt dieses Artikels behandelt die Entwicklung von Quantenwissen in diesem Bereich des menschlichen Wissens, so werden die grundlegenden Konzepte im Zusammenhang mit Erzeugung, Evolution, Umfang, Zukunftsperspektiven und Herausforderungen, die der Berechnung inhärent sind, beschrieben. Quantencharakter.

4. QUANTENBERECHNUNG

Quantencomputer arbeiten im Grunde von Regeln im Zusammenhang mit Quantenunsicherheit. Wenn es das Niveau eines einzelnen Teilchens erreicht, ist nichts absolut (das Elektron kann auf die eine oder andere Weise gedreht werden, aber eine Mischung von Spins kann auch vorhanden sein). Auf Quantencomputern ist die grundlegende Informationseinheit Quantenbits (Qubits). Qubits können Werte von 0 oder 1 sowie reguläre Bits (binäre Zahlen) haben. Der Unterschied besteht darin, dass die Qubits gleichzeitig die Werte 0 und 1 haben können. Es ist in dieser besonderen Eigenschaft, dass es die ganze Rechenleistung von Quantencomputern gibt.

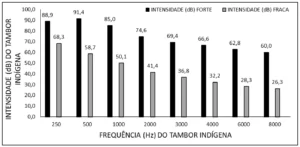

Abbildung 1: Quantenberechnung

Quantenberechnung untersucht die Vorteile einer kohärenten Quantenzustandsüberlagerung, um Quantenparallelität zu erreichen: gleichzeitig die gleiche Operation bei unterschiedlichen Qubits-Werten zu erreichen. Dies ist nur aufgrund des grundlegenden Unterschieds zwischen Qubits (Qubits sind bekannt) und Klassikern möglich: Während klassische Bits nur im Zustand 0 oder 1 sein können, können die Qubits in diesen Zuständen 0 und 1 überlappen. Wenn es zwei Qubits gibt, können die Qubits als Kombination aller möglichen zwei Ziffern existieren. Durch Hinzufügen eines dritten Qubits können alle drei möglichen Bit-Nummern kombiniert werden. Das System ist exponentiell gewachsen. So kann eine Sammlung von Qubits eine Zahlenzeile darstellen und Quantencomputer können gleichzeitig alle Dateneinträge gleichzeitig verarbeiten.

Das Konzept der Quantenberechnung ist nicht so komplex wie die Basismesseinheit der klassische Computer. Dies kann die Werte 0 oder 1 Bit nehmen. Es ist diese Besonderheit, die Quantenstrukturen so mächtig macht. Der beschriebene Vorgänger ist Quantenspin, aber ein Automat wird auch vorgeschlagen, um die Quantenstruktur zu verschieben. Die Grundeinheit dieses Computertyps besteht aus vier Quantenzellen von Quantenpunkten, so dass jede Einheit zwei Elektronen hat, die versuchen, stationär zu bleiben. Mit anderen Worten, in dem Zustand, der weniger Energie verbraucht, zeigt die Coulomb-Formel an, dass die abstoßende Kraft umgekehrt proportional zum Abstand des Abstoßmechanismus ist, so dass je näher die Kraft ist, desto wahrscheinlicher ist es, dass sie abstoßen kann. Daher neigen sie dazu, Quantenpunkte an beiden Enden der Zelle zu besetzen, was dem Drehen auf einem Computer mit Quantenrotation gleichsetzt. Diese Technik erfordert jedoch eine sehr niedrige Betriebstemperatur: 70 mg.

Die Quantenzelle wird verwendet, um eine Struktur zu erzeugen, die durch ein Quanten aus 5 Zellen gebildet wird: drei Eingabezellen, eine Zelle "Manipulation" und eine Ausgabe. Diese Struktur wird als Baumeingabe bezeichnet. Die Funktionsweise der Filamentstruktur in DerGrundform ist wie folgt: Die Abstoßung von Elektronen hält zumindest die Polarisation aufrecht, so dass die behandelten Zellen dazu gebracht werden, den Zustand der meisten Eingangseinheiten anzunehmen. Schließlich kopiert die Ausgabeeinheit das Ergebnis, so dass die Polarisation der Einheit die Berechnung der Verarbeitungseinheit nicht beeinflusst.

Aber es gibt immer noch einige Probleme, nicht in Bezug auf die Architektur, sondern im Prozess der Konstruktion von Quantencomputern, denn einer der Gründe für den Fehler ist die Umwelt selbst: die Auswirkungen auf die Umwelt können Änderungen in den Qubits verursachen, die zu Veränderungen in den Qubits führen können, die zu Inkonsistenzen im System, ungültig. Eine weitere Schwierigkeit besteht darin, dass die Quantenphysik darauf hinweist, dass es notwendig ist, die Überlagerung der Verhaltensfehlerzustände eines Quantensystems zu messen oder zu beobachten. Das heißt, wenn Sie die Daten lesen, während Sie das Programm auf einem Quantencomputer ausführen, geht die gesamte Verarbeitung verloren.

4.1. DIE SHOR ALGORITHM

Die Entwicklung der Quantenberechnung begann im Jahrzehnt des Jahres 1950, als die Gesetze der Physik und Quantenmechanik, die auf die Informatik angewendet wurden, betrachtet wurden. 1981 fand in Massachusetts ein Treffen am Institute of Technology statt: DAS MIT diskutierte dieses Thema. In diesem Treffen schlug der Physiker Richard Feynman den Einsatz von Quantensystemen auf Computern vor und verteidigte, dass sie mehr Rechenleistung haben als normale Computer. 1985 beschrieb David Deutsch von der Universität Oxford den ersten Quantencomputer. Es ist eine Quanten-Turing-Maschine, die einen anderen Quantencomputer simulieren kann. Es gab keine signifikanten Fortschritte in der Forschung zu diesem Thema, so fast ein Jahrzehnt später, Peter Shaw, ein AT & T Forscher, führte 1994 eine Studie durch, um einen Algorithmus zu entwickeln, um viel schneller als herkömmliche Computer zu faktoriieren.

Der Algorithmus verwendet die Eigenschaften eines Quantencomputers, um die Zersetzung großer Ganzzahlen (ca. 10 200 Zahlen) in Polynomzeit durchzuführen. Dieser Algorithmus, der shor-Algorithmus genannt wird, wird im Artikel "Quantum Computation algorithms: discrete logarithms decomposition" veröffentlicht. Der Algorithmus verwendet die Quantenüberlagerungseigenschaft, um die Komplexität des Lösungszeitproblems durch eine spezifische Quantenfunktion vom Exponential zum Polynom zu reduzieren. Das Verständnis der im Shor-Algorithmus verwendeten Quantenfunktionen erfordert eine ziemlich umfangreiche und komplexe mathematische Interpretation, die über den Rahmen dieses Artikels hinausgeht.

Die direkte Anwendung des Shor-Algorithmus ist auf den Bereich der Verschlüsselung anwendbar. Die Sicherheit kryptografischer Systeme mit öffentlichen Schlüsseln hängt von der Schwierigkeit ab, sehr große Mengen zu zersetzen. Die Sicherheit des Verschlüsselungssystems wird durch die tatsächliche Implementierung eines Computers beeinträchtigt, der in der Lage ist, diese Berechnungen schnell durchzuführen. Die US-Raumfahrtbehörde NASA und Google investieren in Quantencomputer für die Zukunft des Computing und bereiten sich auf den Einsatz der neuesten D-Wave-Maschinen vor.

4.2 DER QUANTUM COMPUTER VON D-WAVE

Die neue Version von D-Wave, Quantencomputer wird bei der NASA-Suche nach der außerirdischen Welt helfen, bevor Ende 2013 vor allem wirkt, um den Dienst zu verbessern. D-Wave TWO Computer-1 512-Bit-Computer werden bald im neuen Quantum Artificial Intelligence Laboratory von NASA, Google und USRA (Space University Research Association) eingesetzt. Engineering Director Harmut Neven Google veröffentlichte eine Notiz auf dem Blog des Unternehmens, in der die Ziele der Organisation beschrieben werden. Er glaubt, dass Quantenberechnungen dazu beitragen können, Computerwissenschaftsprobleme in einigen zu lösen, insbesondere im Bereich der künstlichen Intelligenz. Künstliche Intelligenz wird aus den besten Modellen der Welt aufgebaut, um genauere Vorhersagen zu treffen.

Um die Krankheit zu heilen, ist es notwendig, ein effektiveres Modell von Krankheiten zu etablieren, und um eine effektivere Umweltpolitik zu entwickeln, ist es notwendig, bessere globale Klimamodelle zu entwickeln. Um einen nützlicheren Suchdienst zu erstellen, müssen Sie die im Internet verfügbaren Probleme und Inhalte besser verstehen, um die beste Antwort zu erhalten. Neven, so das Kommuniqué, berichtet, dass das neue Labor diese Theorieideen in die Praxis umsetzen wird. Auf diese Weise begannen die Installationsarbeiten der D-Wave-Maschine bei der NASA am Ames Research Center, Moffett in Kalifornien. Googles Hauptsitz in Mountain View, nur wenige Minuten entfernt.

Diese Partnerschaft stellt den jüngsten Durchbruch von D-Wave dar. Die D-Wave ist eine Behauptung, für beide wurde gebaut und verkauft die weltweit erste kommerzielle Quantencomputer von der kanadischen Firma. Viele akademische Labore arbeiten daran, nur eine kleine Qubit Quantencomputernummer zu bauen, die Forscher, die mit D-Wave beschäftigt sind, arbeiten, so dass die Maschine weniger Zweifel lassen kann. Vor einigen Jahren waren viele bekannte Quantencomputer-Spezialisten skeptisch gegenüber IEEE Spectrum. Eigentlich gelang es D-Wave, einige Ex-Comentaristas zu erobern. Das Unternehmen ermöglicht D-Wave den Zugang zu unabhängigen Forschern. In mindestens zwei Fällen hat diese Offenheit zu Implikationen für Vorwürfe der Quantenberechnung und der Unternehmensleistung geführt. D-Wave gewann an Glaubwürdigkeit, als es Lockheed Martin 2011 zum ersten Mal vermarktete.

Nach Angaben des Google-Vertreters hat das neue Quantum Artificial Intelligence Lab die neue D-Wave Two vor der Zulassung der Maschine strengen Tests unterzogen. Insbesondere erfordert ein Test, dass der Computer einige Optimierungsprobleme behebt, mindestens 10.000 Mal schneller als der klassische Computer. In einem anderen Fall erhielt die D-Wave-Maschine die höchste Punktzahl in der Standard-Ausgabe des SAT-Spiels. Seit Jahren verwendet Google D-Wave-Hardware, um Probleme mit maschinellem Lernen zu lösen. Das Unternehmen hat einen kompakten und effizienten Machine Learning-Algorithmus für die Mustererkennung entwickelt, der für leistungsbegrenzende Geräte wie Smartphones oder Tablets nützlich ist. Eine andere ähnliche Maschine erwies sich als sehr geeignet, wenn zum Beispiel ein hoher Prozentsatz von Bildern in Online-Alben falsch sortiert wurde, um die "Verschmutzung" der Daten zu lösen.

Die Nasa hofft unterdessen, dass die Technologie dazu beitragen kann, die Suche nach fernen Planeten rund um das Sonnensystem zu beschleunigen und zukünftige Weltraum-, Mensch- oder Robotermissionskontrollzentren zu unterstützen. Forscher der NASA und von Google werden den Einsatz der neuen D-Wave Twono Labormaschine nicht monopobe. USRA beabsichtigt, das System der amerikanischen akademischen Forschungsgemeinschaft zur Verfügung zu stellen – eine Entscheidung, die D-Wave helfen wird, die Skeptiker zu überwinden. Die Nachricht wurde von der Fluggesellschaft Lockheed Martin gemacht. So kündigte nein Anfang 2013 für eine Milliarde US-Dollar den Kauf der D-Welle zwei kurz darauf an, was die anschließende Aufrüstung auf die Maschine D-Wave One darstellt.

4.3 TEST: DIGITAL COMPUTER X QUANTUM COMPUTER

Zum ersten Mal wurde ein Quantencomputer mit einem gemeinsamen PC konkurrieren – und der Quantencomputer gewann den Streit mit Slack. Der Begriff Quantenberechnung wird immer mit der Idee von "in der Zukunft", "wenn sie Realität werden", "wenn sie gebaut werden können" und solchen Dingen in Verbindung gebracht. Diese Wahrnehmung begann sich 2007 zu ändern, als die kanadische Firma D-Wave einen Computer präsentierte, von dem sie behauptete, Berechnungen auf der Grundlage der Quantenmechanik durchzuführen. Die Skepsis unter Forschern und Gelehrten des Themas war groß. Im Jahr 2011 hatte die wissenschaftliche Gemeinschaft jedoch Zugang zu den Geräten und konnte mehr darüber hinaus, dass der Quantenprozessor von D-Wave wirklich Quanten ist. Nun wurde Catherine McGeoch von der Amherst University in den Vereinigten Staaten von D-Wave beauftragt, einen Vergleich zwischen D-Wave, das "adiabatische Quantenberechnung" verwendet, und einem gemeinsamen PC zu machen. Laut der Forscherin ist dies die erste Studie, die einen direkten Vergleich zwischen den beiden Computerplattformen anstellt: "Dies ist nicht das letzte Wort, sondern ein Anfang in dem Versuch herauszufinden, was der Quantenprozessor tun kann oder nicht."

Der Quantenprozessor, der durch 439 Qubits Niobspulen gebildet wurde, war 3.600 Mal schneller als der gewöhnliche PC bei der Ausführung von Berechnungen mit einem kombinatorischen Optimierungsproblem, das darin besteht, die Lösung einer Gleichung zu minimieren, indem die Werte von bestimmte Variablen. Berechnungen dieser Art sind weit verbreitet in den Algorithmen, die Bilderkennung, Bildsicht und künstliche Intelligenz machen verwendet. Der Quantencomputer von D-Wave fand die beste Lösung in einer halben Sekunde, ungefähr, während der effizienteste klassische Computer eine halbe Stunde benötigte, um das gleiche Ergebnis zu erreichen.

Der Forscher erkennt, dass es kein völlig sauberes Spiel war, da generische Computer in der Regel nicht so gut gegen Prozessoren tun, die sich der Lösung eines bestimmten Problems widmen. Ihr zufolge wird der nächste Schritt des Vergleichs also darin bestehen, den Streit zwischen dem adiabatischen Quantenprozessor und einem klassischen Prozessor zu führen, der für diese Art der Berechnung entwickelt wurde – wie eine GPU, die auf Grafikkarten verwendet wird. Der Forscher hob den spezialisierten Charakter des Quantencomputers hervor und wies darauf hin, dass er hervorragend für die Durchführung von Berechnungen geeignet sei. Es besagt, dass diese Art von Computer nicht dazu bestimmt ist, im Internet zu surfen, sondern löst diese spezifische, aber wichtige Art von Problem sehr schnell.

4.4 TECHNOLOGIEN

Datenpfade zu möglichen Anwendungen für die Quanteninformationsverarbeitung, wie können Sie sie auf realen physischen Systemen ausführen? Auf einer Skala von wenigen Qubits gibt es viele Arbeitsvorschläge für Quanteninformationsverarbeitungsgeräte. Vielleicht ist der einfachste Weg, sie zu erreichen, von optischen Techniken, das heißt von elektromagnetischer Strahlung. Einfache Geräte, wie Spiegel und Balkenteiler, können verwendet werden, um elementare Manipulationen in Photonen durchzuführen. Forscher haben jedoch herausgefunden, dass es sehr schwierig ist, separate Photonen nacheinander zu produzieren. Aus diesem Grund entschieden sie sich für Schemata, die einzelne Photonen "von Zeit zu Zeit" nach dem Zufallsprinzip produzieren.

Die Experimente der Quantenkryptographie, Superdense-Codierung und Quantenteleportation wurden mit optischen Techniken durchgeführt. Ein Vorteil dieser Techniken ist, dass Photonen in der Regel sehr stabile Träger von Informationen aus der Quantenmechanik sind. Ein Nachteil ist, dass Photonen nicht direkt miteinander interagieren. Die Interaktion sollte durch ein anderes Element vermittelt werden, wie von einem Atom, da es zusätzliche Komplikationen mit sich bringt, die das Experiment rauschen lassen. Eine effektive Interaktion zwischen den beiden Photonen erfolgt wie folgt: Die Anzahl der Photonen interagiert mit dem Atom, das wiederum mit dem zweiten Photon interagiert, was zu einer vollständigen Interaktion zwischen den beiden Photonen führt.

Ein alternatives Schema basiert auf Methoden, die verschiedene Arten von Atomen erfassen: Es gibt die Ionenfalle, in der eine kleine Anzahl geladener Atome auf engstem Raum gefangen sind; Und neutrale ionische Fallen werden verwendet, um unbeladene Atome in diesem engen Raum zu erfassen. Quanteninformationsverarbeitungsschemata, die auf Atomfallen basieren, verwenden Atome, um Qubits zu speichern. Elektromagnetische Strahlung tritt auch in diesen Schemata auf (aber anders als im "optischen" Ansatz der Quanteninformationsverarbeitung berichtet). In diesen Schemata werden Photonen verwendet, um Informationen zu manipulieren, die in Atomen gespeichert sind. Einzigartige Quantentüren können durch Die Anwendung geeigneter elektromagnetischer Strahlungsimpulse auf einzelne Atome durchgeführt werden.

Benachbarte Atome können miteinander interagieren, z. B. durch dipolare Kräfte, die die Ausführung von Quantentüren ermöglichen. Darüber hinaus ist es möglich, die genaue Art der Wechselwirkung zwischen den benachbarten Atomen zu ändern, indem entsprechende elektromagnetische Strahlungsimpulse auf die Atome angewendet werden, was es dem Experimentator ermöglicht, die im System ausgeführten Ports zu bestimmen. Schließlich kann die Quantenmessung an diesen Systemen mit der Quantensprungtechnik durchgeführt werden, die Messungen auf der Grundlage der in der Quantenberechnung verwendeten Berechnung genau implementiert. Eine weitere Klasse von Quanteninformationsverarbeitungssystemen basiert auf Kernspinresonanz, die unter den Initialen des englischen Begriffs NMR bekannt ist. Diese Schemata speichern Quanteninformationen in den Kernspins von Atommolekülen und manipulieren diese Informationen mit Hilfe elektromagnetischer Strahlung.

Die Verarbeitung von Quanteninformationen durch NMR steht vor drei besonderen Schwierigkeiten, die diese Technologie von anderen Quanteninformationsverarbeitungssystemen unterscheiden. Zunächst werden die Moleküle vorbereitet und lassen sie bei Raumtemperatur im Gleichgewicht, was viel höher ist als die Energien der Spinrotation, dass die Spins fast vollständig zufällig ausgerichtet werden. Diese Tatsache macht den Ausgangszustand besonders "laut" als wünschenswert, quanteninformationen zu verarbeiten. Ein zweites Problem besteht darin, dass die Klasse der Messungen, die in NMR verwendet werden können, nicht alle Maßnahmen enthält, die für die Verarbeitung von Quanteninformationen erforderlich sind. In vielen Fällen der Quanteninformationsverarbeitung ist jedoch die in NMR zulässige Messklasse ausreichend.

Drittens: Da Moleküle in NMR nicht einzeln behandelt werden können, ist es natürlich, sich vorzustellen, wie einzelne Qubits angemessen behandelt werden können. Unterschiedliche Kerne des Moleküls können jedoch unterschiedliche Eigenschaften aufweisen, die es ermöglichen, sie einzeln anzunähern – oder zumindest in einer ausreichend granularen Skala zu verarbeiten, um die wesentlichen Vorgänge der Datenverarbeitung zu ermöglichen. Quantum. Das IBM Almaden Research Center hat hervorragende Ergebnisse erzielt: Eine Quantenmaschine mit sieben Atomen und NRM wurden erfolgreich gebaut und korrekt den Shor-Algorithmus mit Faktor 15 ausgeführt. Dieser Computer verwendete fünf Fluoratome und zwei Kohlenstoffatome.

4.5 PROBLEME

Die Hauptschwierigkeit beim Bau von Quantencomputern ist die hohe Fehlerhäufigkeit. Einer der Gründe für die Definition des Fehlers selbst ist, dass der Einfluss der Unterstützung auf den Quantencomputer zu einer Variante des Qubits führen kann. Durch Deaktivieren aller Berechnungen können diese Fehler zu Systeminkonsistenzen führen. Eine weitere Schwierigkeit ist also die Bedeutung der Quantenmechanik, das Prinzip, das Quantencomputer so interessant macht. Die Quantenphysik behauptet, dass das Messen oder Beobachten eines Quantensystems die Überlagerung von Zuständen zerstören kann. Das bedeutet, dass, wenn Ihr Programm Daten liest, während es auf einem Quantencomputer läuft, die gesamte Verarbeitung verloren geht.

Die größte Schwierigkeit ist die Fähigkeit, Fehler zu korrigieren, ohne das System tatsächlich zu messen. Dies wird durch Phasenkonsistenz erreicht. Diese Technologie kann Fehler beheben, ohne das System zu beschädigen. Dazu wird die Magnetresonanztomographie verwendet, um ein einzelnes Bit phonetronischer Quanteninformationen aus einem trinuklearen Trichlorethylenmolekül zu replizieren. Grundsätzlich verwendet diese Technik indirekte Beobachtungen, um Inkonsistenzen durchzuführen und die Systemkonsistenz aufrechtzuerhalten. Angesichts all dieser Schwierigkeiten liegt die Bedeutung der Erfahrung von IBM auf der Hand: Wissenschaftler können all diese Rückschläge überwinden und sie vom Shore-Algorithmus auf Quantencomputern in die Praxis umsetzen.

5. BLOCKCHAIN

Die Blockchain, oder "Block-Kette", ist eine Art dezentrale Datenbank in einer bestimmten Software enthalten, die vor allem arbeitet, um die Authentizität von Bitcoins und Transaktionen zu überprüfen, wo alle Aktivitäten aufgezeichnet werden Hergestellt mit Bitcoin-Währungen, so dass es möglich ist, die Integrität der Währung zu überprüfen und Fälschungen zu verhindern. Grundsätzlich werden die darin generierten Informationen, wenn eine Transaktion ausgeführt wird, der Blockchain hinzugefügt, die als Datensatz fungiert. Wenn eine Transaktion überprüft werden muss, scannen die Kunden, die für die Überprüfung verantwortlich sind, den Inhalt der Transaktionen im Zusammenhang mit dem betreffenden Bitcoin, so dass neben Fälschungen auch die "doppelten Ausgaben" derselben Währung verhindert werden.

Die Zeitstempelserver dienen dazu, sicherzustellen, dass bestimmte Informationen zu einem gültigen Zeitpunkt vorhanden sind oder vorhanden sind, um sicherzustellen, dass die von ihr abhängigen Vorgänge anschließend authentisch sind. Das Problem mit dieser Überprüfung in Bitcoins ist, dass es keinen zentralisierten Server gibt, der diese Überprüfungen durchführen und den Kunden die Integrität der Informationen gewährleisten kann, so dass diese Überprüfung durchgeführt wird, wurde die Proof-of-Work-Technik übernommen. Es handelt sich um eine Technik, die eine bestimmte Menge an Informationen validiert und je nach Komplexität eine Menge Verarbeitungszeit benötigt, um validiert zu werden.

Bitcoin verwendet diese Technik, um die Generierung neuer Blöcke zu validieren, basierend auf dem Hashcash-System. Damit also ein Block erfolgreich generiert werden kann, wird ein Teil seines Codes im Netzwerk veröffentlicht, so dass andere Blöcke ihn validieren und akzeptieren und so zu einem gültigen Block werden.

6. TYPEN VON PROZESSOREN

Aufgrund der sogenannten Stickstoffvakuumstruktur wurden die Diamanten von mehreren Teams von Wissenschaftlern beeinflusst, die Quantenprozessoren bauten. Nun hat ein internationales Forscherteam bewiesen, dass es nicht nur möglich ist, einen Quantencomputerdiamanten zu bauen, sondern ihn auch vor den Ergebnissen zu schützen. In diesem Zusammenhang ist Konsistenz eine Art von Rauschen oder Interferenzen, die die subtile Beziehung zwischen den Qubits stört. Wenn es eintritt, befinden sich die Teilchen gleichzeitig in Punkt A und Punkt B, beginnen plötzlich an Punkt A oder nur an Punkt B. So hat ein anderes Team einen Quanten-Festkörperprozessor mit Halbleitermaterialien erstellt. Da Gas- und Flüssigkeitssysteme heute die überwiegende Mehrheit der Quantencomputerexperimente ausmachen, haben Quantenprozessor-Feststoffe den Vorteil, dass sie ohne wesentliche Komplikationen in Quantenzahlen wachsen können.

Der Quantendiamant ist so einfach wie möglich: Er hat zwei Qubits. Trotz des vollen Kohlenstoffs enthalten alle Diamanten Verunreinigungen, d. h. Atome, die in ihrer atomaren Struktur "verloren" sind. Es sind diese Verunreinigungen, die das Interesse von Wissenschaftlern geweckt haben, die den Bereich der Quantenberechnung denken. Der erste ist der Stickstoffkern, während der zweite ein einzelnes "wanderndes" Elektron ist, aufgrund eines weiteren Defekts in der Struktur des Diamanten – in der Tat ist das Bit die Drehung jedes einzelnen. Elektronik funktioniert besser als Bits als Kerne, da sie Berechnungen schneller durchführen können. Auf der anderen Seite sind sie die häufigsten Opfer von Kohärenz.

6.1 ANWENDUNGEN

Von der Energie des Prozessors wäre diese Behandlung sehr nützlich für die wissenschaftliche Forschung, so dass es natürlich in diesen Supercomputern die kommerzielle Anwendung der virtuellen Realität und künstliche Intelligenz gestartet werden soll, wie es werden soll Eine Mode dieses Jahrhunderts. Das Spiel kann wirklich ausreichen, um einige Charaktere zu enthalten, die mit dem gespielten interagieren. Sie können auf der Grundlage der Aktionen des Spielers sprechen und handeln, wie z. B. ein fast Echtzeit-RPG. Ein einzelner Quantencomputer kann Hunderte dieser Zeichen in Echtzeit steuern. Die Erkennung von Klängen und Gesten ist trivial. Es besteht kein Zweifel daran, dass es in verschiedenen Bereichen, die künstliche Intelligenz denken, ausdrucksstarke Fortschritte gegeben hat.

Mit der Weiterentwicklung der Forschung wird es einen sicheren Verschlüsselungscode für den Einsatz intelligenter Algorithmen für große Datenbankerhebungen sowie für die Realisierung von künstlichen Intelligenz-Tracking fast sofort, und doch für die Datenübertragung auf schnelle Weise. Die Verwendung von Glasfasern und Terabytes mit hoher Dichte pro Sekunde und Quantenmechanik-Router nützen diese Informationen. Die Umwandlung des Internets in eine virtuelle Welt ist genug, denn in einer virtuellen Welt können sich Menschen in die Avatare integrieren und sich auf Sprache, Gesten und sogar Berührung beziehen, wie in der realen Welt. Dies wird die Entwicklung der laufenden Diskussionen sein. Die wichtigste Frage ist, wann. Niemand weiß wirklich, wie schnell diese Forschung ist. Es kann hundert Jahre dauern, bis die Anwendung läuft, oder nur zwanzig oder dreißig Jahre.

6.2 WIE SIE ARBEITEN

Der erste Quantencomputer wurde Realität, zum Beispiel startete IBM seinen ersten Quantenchip in der 12. Sitzung der University of Palo Alto in diesem Jahr. Es ist immer noch ein sehr einfaches Projekt mit nur fünf Qubits, nur 215 Hz sowie erfordert viele Geräte zu arbeiten, aber es hat sich gezeigt, dass es ein Quantenprozessor ist, die derzeit möglich ist. Die erste Frage dieses Experiments ist, wie dieses Molekül stabil zu halten. Die derzeit im Einsatz befindliche Lösung besteht darin, sie in einer Hochtemperatur-Kühllösung nahe dem absoluten Nullpunkt zu lagern. Allerdings ist dieses System sehr teuer. Um kommerziell rentabel zu sein, müssen sie diese Einschränkung überwinden, indem sie Quantenprozessoren schaffen, die bei Raumtemperatur arbeiten können.

Das zweite Problem ist, wie man die Atome manipuliert, aus denen der Prozessor besteht. Ein Atom kann den Zustand mit einer alarmierenden Geschwindigkeit ändern, aber ein Atom kann den Zustand, den es aufnehmen möchte, nicht erraten. Um Atome zu manipulieren, verwenden Sie kleinere Partikel. Die von IBM-Designern entdeckte Lösung besteht darin, Strahlung in einem System zu verwenden, das der Magnetresonanz ähnelt, aber genauer. Dieses System hat zwei Probleme, das erste ist die Tatsache, dass es sehr teuer ist: ein Gerät, wie ein Blatt, ist nicht weniger als 5 Millionen US-Dollar. Das zweite Problem ist, dass die Technik sehr langsam ist, was beweist, dass der Prototyp des IBM-Rades nur 215 Hz ist, millionenfach schneller als jeder aktuelle Prozessor, der sich bereits in der Gigahertz-Box befindet. Ein weiteres Hindernis, das Quantum überwinden muss, ist die wirtschaftliche Lebensfähigkeit.

6.3 NEUE HOFFNUNGEN

Wie wiederholt, sind die experimentellen Quantenprozessoren, die bisher entwickelt wurden, langsam, da sie über normale neue Technologien verfügen und komplexe und kostspielige Geräte erfordern. Es ist nicht so einfach, zu verpacken wie Intel oder AMD Prozessoren und arbeiten bei Raumtemperatur, unterstützt durch einen einfachen Kühler. Der aktuelle Quantenprototyp nutzt das NMR-Gerät, um den Zustand von Atomen und Molekülen zu manipulieren, um bei Temperaturen nahe dem absoluten Nullpunkt stabil zu bleiben. Obwohl es Wissenschaftlern hilft, Quantenmechanik zu studieren, sind solche Systeme nie wirtschaftlich lebensfähig. Heute gewinnt die Entwicklung der Quantenprozessoren an Dynamik. Das erste Experiment versuchte zu beweisen, dass es sich um eine sehr problematische elektronische Manipulation handelt, da die Elektronen aufgrund ihrer geringen Qualität und Exposition sehr empfindlich auf jeglichen äußeren Einfluss reagieren.

Sie manipulieren dann den Kern, was den Prozess erheblich vereinfacht, weil der Kern höher ist und die Idee durch die Elektronenbarriere um ihn herum relativ isoliert von der äußeren Umgebung ist. Aber das ist nur ein Teil der Lösung. So oder so, Sie müssen immer noch eine Technik entwickeln, um den Kern zu manipulieren. Die erste Gruppe verwendet MRT, einen sehr teuren technischen Prototyp, aber es gibt bereits Leute, die einen einfacheren Weg entwickeln, dies zu tun. Wissenschaftler des Los Alamos National Laboratory in den Vereinigten Staaten haben Experimente veröffentlicht, die mit Hilfe von Optik Protonen manipulieren. Die Idee dieser neuen Technologie ist, dass Protonen in Form von Wellenformen (die mit den Atomen interagieren, die das Quantensystem bilden) verwendet und durch ein optisches System transportiert werden können.

Mit dieser neuen Technologie haben Protonen die Funktion, die Atome zu manipulieren, aus denen der Quantenprozessor besteht. Da es sich um ein Teilchen handelt, kann ein Proton gegen ein Qubit "geworfen" werden, was seine Bewegung und Wirkung verändert. Ebenso können Protonen emittiert werden, um zu den Qubits zu springen. So wird die Flugbahn des Protons verändert. Der große Balkon kann verwendet werden, um dieses Proton mit einem Photodetektor zu bergen, der Protonen in der Wellenform erkennt, nicht Partikel. Durch die Berechnung des Pfads des Protons können die in den Bits aufgezeichneten Daten abgerufen werden.

Ein Während des Experiments auftretendes Problem war, dass es viele Fehler im System gab. Dazu arbeiten die Forscher an fehlerkorrigierenden Algorithmen, die das System zuverlässig machen. Nach all dieser Arbeit wird der Quantencomputer wahrscheinlich lebensfähiger werden als erwartet. Vor fünfzehn Jahren galten Quantencomputer nur als Science Fiction. Heute sind einige Prototypen bereits in Betrieb. Die Frage ist nun, wann sind diese Systeme lebensfähig? Der Fortschritt, den wir sehen, könnte die Antwort sein.

FAZIT

Um die meisten mathematischen Berechnungen durchzuführen, Text zu bearbeiten oder im Internet zu surfen, ist die beste Lösung, den nächstgelegenen Computer zu verwenden (basierend auf der Von Neumann-Architektur). Tatsächlich sind die heutigen Prozessoren sehr effektiv bei der Ausführung dieser Aufgaben. In Bereichen wie künstlicher Intelligenz ist es jedoch notwendig, andere Arten von Computern und Architekturen zu verwenden. Bei Bilderkennungs- oder Sprachverarbeitungsalgorithmen wird beispielsweise die sequenzielle Ausführung und Speicherung der Von Neumann-Architektur (sehr effektiv für andere Anwendungen) zu einer Einschränkung, die die Leistung dieser Systeme einschränkt.

Für diese Art von Anwendung ist es interessanter, einen Computer mit ausreichender Verarbeitungskapazität zu haben, um das Formular zu identifizieren (das gemeinsame Prinzip der Lösung dieser Probleme). Unter den verschiedenen Alternativen sind Quantencomputer die vielversprechendsten, gerade weil sich die Quantenberechnung von Neumanns Struktur durch eine enorme parallele Rechenleistung unterscheidet.

Daher kann der Schluss gezogen werden, dass Quantencomputer verwendet werden, um die Probleme, die von den klassischen Computern gelöst werden, effektiv anzugehen. Die Quantenberechnung wird auf Probleme angewendet, bei denen keine effektive Lösung gefunden wurde, wie künstliche Intelligenz und Verschlüsselung. Quantenberechnung kann die extrem komplexen Probleme des klassischen Computing vollständig lösen. Die Schwierigkeit, diese Phänomene zu bewältigen und vor allem die evolutionäre Architektur umzusetzen, lässt jedoch viel Unsicherheit für den Erfolg dieser Maschinen. Große Unternehmen wie IBM investieren in die Forschung in diesem Bereich und entwickeln bereits die ersten Prototypen. Algorithmen zur Lösung dieses neuen Paradigmas sind bereits in der Entwicklung und sogar die Entwicklung von Programmiersprachen.

Es bleibt zu wissen, ob das Problem gelöst werden kann, ob es sich um ein Investitionsproblem und zeitgleich handelt oder ob es eine physikalische Grenze gibt, die die Schaffung einer Maschine verhindert, die die aktuelle Maschine überwinden kann. Wenn dies möglich ist, könnte es einen Quantenkoprozessor geben, der zusammen mit dem Siliziumprozessor einen zukünftigen Computer darstellt, der die Zeit genauer vorhersagen und den Komplex verfeinern kann.

BIBLIOGRAPHISCHE HINWEISE

ACM Computing Surveys, v. 32, n. 3, p. 300-335, 2000.

BECKET, P J. A. Para a arquitetura dos nanomateriais. In: 7ª Conferência Ásia-Pacífico sobre Arquitetura de Sistemas de Computação, Melbourne, Austrália – Conferência sobre Pesquisa e Prática em Tecnologia da Informação, 2002.

BONSOR, K; STRICKLAND, J. Como funcionam os computadores quânticos. Disponível em: http://informatica.hsw.uol.com.br/computadores-quanticos2.htm. Acesso em: 9 mai 2019.

CHACOS, B. Além da Lei de Moore: Como Fabricantes Estão Levando os Chips ao Próximo Nível. Disponível em http://pcworld.uol.com.br/noticias/2013/04/17/alem-da-lei-de-moore-como-fabricantes-estao-levando-os-chips-ao-proximo-nivel/. Acesso em: 10 mai 2019.

FREIVALDS, R. Como simular um livre arbítrio em um dispositivo de computação? AMC, 1999.

GERSHENFELD, N; WEST, J. O computador quântico. Scientific America, 2000.

HSU, J. Google e NASA estarão usando um novo computador D-Wave. Disponível em http://itweb.com.br/107695/google-e-nasa-to-use-new-d-wave/computer. Acesso em: 10 mai 2019.

KNILL, E. Quantum aleatório e não determinístico. Laboratório Nacional Los Alamos, 1996.

MELO, B. L. M; CHRISTOFOLETTI, T. V. D. Computação Quântica – Estado da arte. Disponível em http://www.inf.ufsc.br/~barreto/trabaluno/TCBrunoTulio.pdf . Acesso em: 10 mai 2019.

NAUVAX, P. Arquiteturas de computador especiais. Disponível em http://www.dct.ufms.br/~marco/cquantica/cquantica.pdf . Acesso em: 10 mai 2019.

NIEMIER, M.T; KOGGE, P. M. Exploração e exploração de dutos de nível de cabo Tecnologias emergentes. IEEE, 2001.

RESENDED, A. M. P; JÚNIOR, A. T. da. C. Projeto de Pesquisa PIBIC/CNPq. Disponível em http://www.ic.unicamp.br/~rocha/sci/qc/src/corpoProjeto.pdf . Acesso em: 11 mai 2019.

RIEFFEL, E; WOLFGANG, P. Introdução à computação quântica para não-físicos.

SARKAR, P. Uma breve história de autômatos celulares. ACM Computing Surveys, v. 32, n. 1, 2000.

SKADRON, K. O Papel da Arquitetura de Processador em Ciência da Computação. Comitê sobre os Fundamentos da Computação. Academia Nacional de Ciências, 2001.

WIKILIVROS. Breve introdução à computação quântica. Disponível em http://wikibooks.org/wiki/Breed_introduction_quantum_computation/Print . Acesso em: 10 mai 2019.

[1] Bachelor of Business Administration.

Eingereicht: Mai 2019.

Genehmigt: Juni 2019.