ARTIGO ORIGINAL

MOURÃO, Rafael de Melo [1]

MOURÃO, Rafael de Melo. Benefícios na utilização de servidores virtualizados: Economia financeira e facilidade na manutenção e migração. Revista Científica Multidisciplinar Núcleo do Conhecimento. Ano 06, Ed. 02, Vol. 12, pp. 05-32. Fevereiro de 2021. ISSN: 2448-0959, Link de acesso: https://www.nucleodoconhecimento.com.br/tecnologia/servidores-virtualizados, DOI: 10.32749/nucleodoconhecimento.com.br/tecnologia/servidores-virtualizados

RESUMO

A virtualização é uma tendência em Tecnologia da Informação (TI). Apesar de iniciada nos anos de 1960, a virtualização tem-se mostrado como uma alternativa promissora para muitas organizações, já que empresas de todos os tamanhos investem nestas tecnologias para colher seus benefícios: economia de energia, provisionamento de servidores e desktops, redução de servidores físicos, maior tempo de atividade e disponibilidade e melhor recuperação em caso de desastres. Mudar para a virtualização significa que as cargas de trabalho que acontecem nos servidores não estão vinculadas a uma peça específica de hardware físico e que várias cargas de trabalho virtuais podem ocorrer simultaneamente no mesmo equipamento. Os benefícios imediatos da virtualização incluem taxas mais altas de utilização do servidor no data center e custos mais baixos, mas também há vantagens mais sofisticadas. Desta forma, este artigo busca evidenciar a prática da virtualização de servidores e seus benefícios para as organizações. Para tal, explora-se, através de uma revisão da literatura, livros, revistas, jornais, entre outras fontes confiáveis, o contexto da virtualização e exemplos da aplicação que evidenciam tais vantagens.

Palavras-Chave: Servidores, virtualização, data Center, benefícios, TI.

1. INTRODUÇÃO

A virtualização de servidores provou ser uma solução de tecnologia revolucionária para gerenciamento de TI, apresentando recursos que nunca seriam possíveis em uma infraestrutura física. Do ponto de vista econômico, os benefícios da virtualização de servidor concentram-se na economia de custos porque permite que vários aplicativos sejam instalados em um único servidor físico (LIMA et al., 2012).

A virtualização de servidor é a ideia de pegar um servidor físico, com a ajuda de um software de virtualização, particionar o servidor ou dividi-lo, de forma que apareça como vários “servidores virtuais”, cada um dos quais pode executar sua cópia de um sistema operacional. Dessa forma, em vez de todo o servidor dedicado a uma coisa, ele pode ser usado de várias maneiras diferentes (CHOINACKI, 2016).

Atualmente vive-se uma época de pandemia causada pela COVID-19, e economia e peça chave para organizações pequenas, médias e grandes. Todos os esforços estão voltados para economia, em todos os setores. Estas ações são antigas, pois quando se economiza, permite-se que tais organizações possam dispor de novas tecnologias e aprimorar seus produtos e serviços. Desta forma, a economia de espaço físico, energia, equipamentos de hardware, etc., são poupados com a virtualização de servidores, permitindo que empresas possam controlar mais, dispor de mais, por menos recursos econômicos.

Neste sentido, este artigo objetivo evidenciar a prática de virtualização de servidores, independente do tamanho da organização, relatando seus benefícios, vantagens econômicas, recursos administrativos para servidores, entre outros, relacionando com a computação em nuvem, que atualmente e praticada por várias organizações, visando justamente à redução de custos.

Sabe-se que a virtualização de servidor é importante porque é mais eficiente que usar servidores individuais para cada aplicativo ou tarefa, ela não apenas reduz o número de servidores disponíveis, mas também simplifica o gerenciamento destes, reduzindo os custos associados à sua hospedagem e manutenção, resultando uma redução no gasto de recursos.

A metodologia aplicada neste artigo é baseada na exposição do referencial teórico, além de análise dados obtidos em pesquisas quantitativas de fontes diretas (livros e obras autorais publicadas) e indiretas (teses de doutorado, mestrados, artigos, revistas, jornais, etc.) evidenciando tais práticas e benefícios que a virtualização de servidores traz para empresas de uma forma geral.

2. ENTENDENDO O QUE É VIRTUALIZAÇÃO DE SERVIDORES: CONCEITOS E CARACTERÍSTICAS

A Recovery (2016) menciona que a virtualização de servidor é o processo de reestruturação de um único servidor em vários servidores virtuais pequenos e isolados. Este processo não requer servidores novos ou adicionais; em vez disso, o software ou hardware de virtualização pega o servidor existente e o particiona em vários servidores virtuais isolados. Cada um desses servidores é capaz de funcionar de forma independente.

Os servidores são a tecnologia que hospeda arquivos e aplicativos, fornecendo funcionalidade para outros programas. Este dispositivo processa solicitações e entrega dados a outros computadores em uma rede local (LAN) ou rede remota (WAN). Os servidores costumam ser muito poderosos, processando tarefas complexas com facilidade (CHOINACKI, 2016).

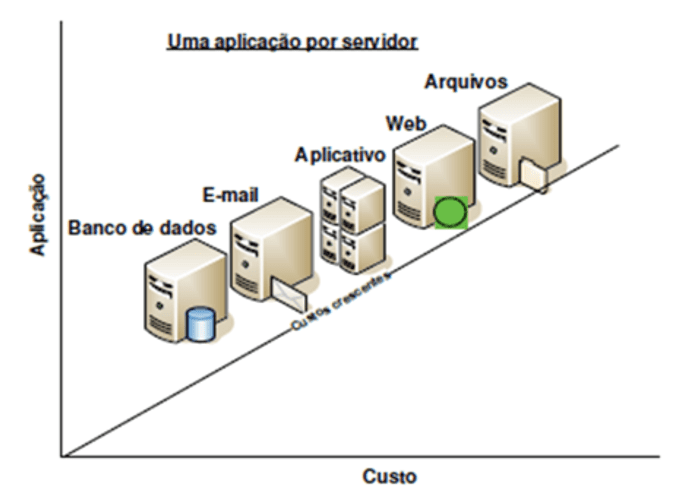

Um único servidor pode usar apenas um sistema operacional (SO) e geralmente é dedicado a um único aplicativo ou tarefa. Isso ocorre porque a maioria dos aplicativos não funciona de forma eficaz em conjunto em um único servidor. Por causa disso, muitos dos recursos de processamento de um servidor ficam sem uso.

A figura 01 abaixo, demonstra bem o conceito dos servidores por aplicação. Tal exposição é sob a concepção do autor (CHOINACKI, 2016)

Figura 1 – Características dos servidores

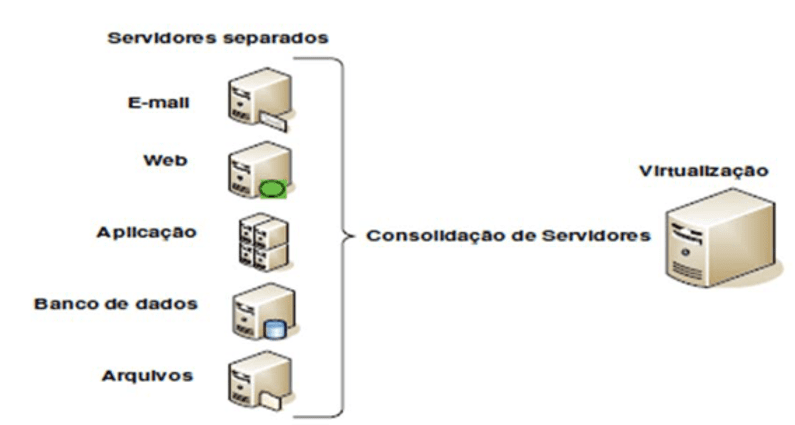

No entanto, quando um servidor é virtualizado, ele é transformado em vários servidores virtuais, cada um dos quais pode executar diferentes sistemas operacionais e aplicativos em um ambiente isolado. Isso significa menos energia de processamento desperdiçada.

Ainda sob a concepção exploratória de (CHOINACKI, 2016), a Figura 02 abaixo, exemplifica como fica um servidor virtualizado, se comparado ao exemplo da Figura 01, do mesmo autor.

Figura 2 – Características dos servidores virtualizados

Os servidores ocupam espaço e requerem manutenção, bem como precisam ser alojados em um ambiente fresco e sem poeira. Entre os custos de hardware, custos de manutenção e custos de resfriamento, isso muitas vezes pode se tornar um custo significativo para as organizações. Na maioria dos casos, a virtualização de servidor é a melhor maneira de gerenciar as necessidades de servidor de um data center.

Como a maioria dos novos aplicativos exige um servidor novo, ter uma configuração de um servidor por aplicativo geralmente significa comprar e instalar um novo servidor físico. Isso pode ser demorado, geralmente levando semanas. No entanto, com servidores virtuais, o provisionamento e a implantação do servidor são simples e rápidos, pois não existe nenhum novo servidor ou instalação.

A virtualização de servidor facilita a implementação de um plano de recuperação de desastres eficaz. Isso ocorre porque se tem uma capacidade de mover dados ou aplicativos rapidamente de um servidor para outro. Um único servidor pode hospedar um grande número de máquinas virtuais (VMs). Por causa disso, pode ser simples e eficaz criar um site de replicação. A maioria dos softwares de virtualização também permite que se teste failovers de recuperação de desastres – um protocolo que é quase impossível com um grande número de servidores físicos.

2.1 PERSPECTIVAS DE VIRTUALIZAÇÃO DE SERVIÇOS EM NUVEM

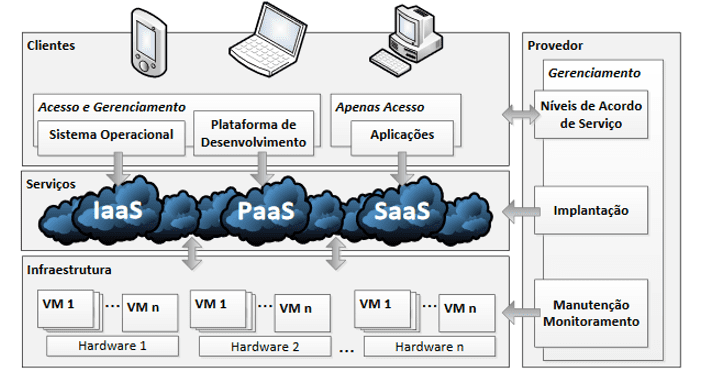

A computação em nuvem é uma das tendências de TI mais atuais porque se trata de economizar dinheiro e simplificar a vida dos usuários. Na computação em nuvem, grandes pools de sistemas de computador compartilham uma infraestrutura de TI, permitindo que produtos, serviços e soluções sejam acessados e consumidos em tempo real pela Internet, normalmente por meio de um modelo de assinatura (BACELAR et al., 2012).

Abaixo na Figura 03, Bacelar (et al., 2012), dimensiona sobre um modelo de serviço computacional em nuvem que as empresas buscam oferecer através de contratos específicos com seus clientes.

Figura 3 – Serviços computacionais em nuvem

A computação em nuvem fez parte do relatório especial do Hype Cycle do Gartner de 2009. A empresa de pesquisa apontou que as empresas ainda estão muito interessadas em aprender mais sobre como consumir serviços de TI da maneira mais econômica. Uma das soluções que eles estão procurando é como acessar serviços como poder computacional, armazenamento e aplicativos de negócios da nuvem, em vez de equipamentos localizados no local (TAURION, 2009).

Embora todos os tipos de fornecedores, da Microsoft ao Google e Salesforce.com, tenham se esforçado muito para explicar sua visão única da computação em nuvem e suas estratégias para avançar com essa tecnologia, o Gartner apontou que a computação em nuvem é um conceito em evolução que provavelmente levará vários anos para amadurecer (TAURION, 2009).

A computação em nuvem provavelmente será uma coisa boa para o crescimento geral dos empregos de TI, mas haverá alguns problemas de crescimento. A capacidade de otimizar e cortar custos por meio da virtualização, automação e simplificação da configuração do software geralmente significa que os departamentos de TI podem fazer mais com menos em certas áreas, mas também significa que os fundos podem ser liberados e podem ser potencialmente realocados para outras áreas de TI onde mais pessoal é necessário.

Além disso, se mais empresas estiverem aproveitando as vantagens da computação em nuvem, os fornecedores que fornecem esses serviços e a infraestrutura relacionada terão que crescer para acompanhar a demanda. Mas se é um administrador de sistemas veterano procurando fazer uma mudança de carreira, não espere mudar para um emprego de computação em nuvem se não tiver mantido suas habilidades atualizadas. Espera-se muita concorrência de novos graduados universitários que serão muito bem versados na Internet e no modelo sob demanda.

Entende-se que a perspectiva é de que alguns empregadores vão querer que se tenha exposição ou experiência de trabalho com as tecnologias de uma das quatro grandes empresas de computação em nuvem: Amazon, Google, Microsoft ou Salesforce.com e / ou experiência de trabalho com tecnologias de virtualização, como a VMWare.

2.2 OS RISCOS DA VIRTUALIZAÇÃO DE SERVIDORES: ENTENDENDO A SEGURANÇA

Não há dúvidas sobre os benefícios da virtualização de servidor. Junto com a virtualização, vêm os recursos maximizados, menos custos e outros pontos positivos. No entanto, como acontece com tudo relacionado à tecnologia, também existem riscos de virtualização de servidores, principalmente relacionados à segurança.

É importante estar ciente desses problemas para que se possa mitigá-los adequadamente. O número de profissionais de TI que implementam a virtualização de servidores continua a subir até quase parecer onipresente agora, embora alguns ainda estejam adiando o aprendizado dessa nova tecnologia devido a preocupações com a adoção. Embora isso tenha sido realizado em 2014, a Pesquisa Global de Riscos de Segurança de TI realizada pela Kaspersky Lab mostrou que 43% dos entrevistados (de um total de 4.000) alegaram que preocupações com a segurança os impediam de usar a virtualização (KASPERSKY, 2014).

Entre esses mesmos participantes, 41 por cento concordaram que “lutam para gerenciar as soluções de segurança em [seu] ambiente virtual”. O verdadeiro problema surge quando 46 por cento dos entrevistados acreditam que as soluções de segurança convencionais protegem ambientes virtuais tão bem quanto ambientes físicos. Além disso, “apenas um em cada três especialistas em segurança de TI expressou um‘ entendimento claro ’do agente leve e segurança de virtualização baseada em agente”, enquanto “apenas um em cada quatro expressou um‘ entendimento claro ’da segurança de virtualização sem agente”. Além disso, 36% acreditam que os ambientes virtuais têm menos preocupações com a segurança do que os físicos. Por causa disso, mais da metade admitiu que sua empresa não implementou totalmente soluções de segurança para seu ambiente virtual (KASPERSKY, 2014).

Diante a pesquisa, pode-se presumir que esses números melhoraram nos últimos anos, com os profissionais de TI se tornando mais conscientes das preocupações que enfrentam os servidores virtualizados. Atualmente, existem malwares que buscam e visam especificamente ambientes virtuais – incluindo a capacidade de residir na memória e saltar de uma máquina virtual para outra para evitar a remoção, mesmo que todo o servidor virtual seja apagado e reconstruído.

De acordo com a INFOSEC (2018), é importante entender que:

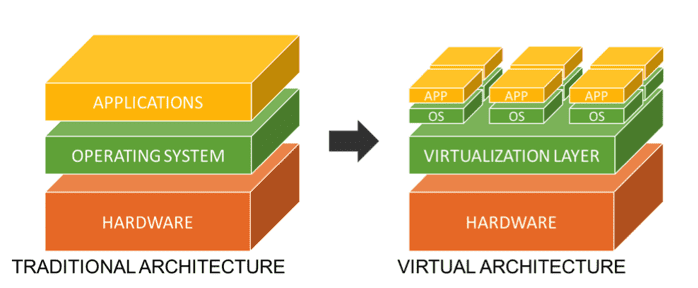

Como o nome sugere, a virtualização cria uma versão virtual em vez de física de algo, como sistemas operacionais, servidores, dispositivos de armazenamento ou recursos de rede. As tecnologias virtualizadas são separadas do hardware subjacente em que são executadas, o que significa que não precisam de uso total do hardware; várias tecnologias virtualizadas diferentes, portanto, podem ser executadas no mesmo equipamento, resultando em maior eficiência e flexibilidade para os operadores do sistema.

Desta forma, a gigante menciona que é preciso estabelecer uma arquitetura básica para virtualização de servidores afim de garantir uma segurança desejável, que atenda e cumpra com os mínimos requisitos exigidos para a proteção de dados. A imagem 04, abaixo (proposta do modelo), ajuda a compreender tal representação.

Figura 4 – Proposta de modelo de arquitetura para virtualização segura

Os ambientes virtuais são certamente tão arriscados quanto os ambientes físicos, e são necessários cuidados diferentes para proteger esses servidores virtuais. Esses problemas comuns relacionados à virtualização acontecem independentemente do fornecedor ou arquitetura, de acordo com o CSA (Cloud Security Aliance – Aliança de Segurança na Nuvem), e geralmente se enquadram em problemas de arquitetura, software de hipervisor ou configuração (CSA, 2015).

Um dos problemas mais comuns surge quando se virtualiza vários servidores. A expansão da máquina virtual (VM) prolifera, e se descontrola, podendo levar a uma condição incontrolável de máquinas sem patch e sem conta. Essencialmente, as VMs são tão simples de criar e implementar com a nova tecnologia de hoje (PAIVA, 2019).

Este é certamente um aspecto positivo das VMs que beneficia os usuários. Mas se o administrador não entender como gerenciar tantas máquinas, podem ocorrer problemas. Além disso, mover VMs de um servidor físico para outro, cria complexidade de auditoria e monitoramento de segurança e perda de controle potencial. Independentemente de se ê ter muitos tipos diferentes de configurações entre suas diferentes máquinas ou duplicar máquinas e depois esquecê-las, pode-se deixar as VMs ficando para trás quando se trata de gerenciar, corrigir e protegê-las.

Sem patches frequentes, as máquinas se tornam mais vulneráveis a ataques, enfraquecendo muito a segurança de toda a sua infraestrutura. Alguns usuários acreditam que, como as VMs estão isoladas na rede, sua segurança não é importante (PAIVA, 2019). No entanto, não corrigir suas máquinas virtuais ainda cria uma vulnerabilidade em sua rede da qual os hackers podem se beneficiar. De acordo com (SERGIO, 2017), existem certas etapas que se pode seguir para garantir que a expansão da VM não aumente os riscos de virtualização do servidor. Isso inclui:

- Colocar ferramentas adequadas de gerenciamento do ciclo de vida (incluindo autoatendimento e scripts automatizados).

- Usar processos formais de gerenciamento de mudanças e ferramentas para controlar a criação, o armazenamento e o uso de imagens de VM.

- Certificar de ter atualizado as imagens do sistema operacional convidado armazenadas separadamente para uso para recuperação e restauração rápidas do sistema.

- Descobrir, classificar e implementar controles de segurança apropriados para cada VM e suas conexões de rede associadas.

- Corrigir e proteger as alterações de configuração com soluções de gerenciamento.

Outro problema decorrente são os roubos através do portal de autoatendimento. Portais de autoatendimento podem ajudar os administradores a obter acesso a partes específicas de sua infraestrutura virtual. O problema com isso começa quando se cria muitos portais, pois isso pode aumentar sua suscetibilidade a sequestro de conta ou serviço, bem como outros riscos (CSA, 2015). Desta forma, se há a concessão de vários privilégios de administração, não haverá um controle de autenticação forte, levando a vulnerabilidades. De acordo com o CSA (2015), existem algumas soluções simples que se pode implementar para controlar esse potencial violação de segurança, incluindo:

- Seja muito seletivo sobre quais usuários precisam de acesso a quais partes de sua infraestrutura.

- Se possível, use autenticação multifator e / ou controle dividido.

- Detecte atividades não autorizadas por meio de monitoramento proativo.

- Gerencie com segurança contas, identidades e credenciais.

Os riscos de API do provedor de serviços em nuvem, também são fatores que devem ser considerados. Se as empresas empregarem uma abordagem de nuvem híbrida, como muitas fazem atualmente, pode ser um desafio mesclar com segurança seus serviços de infraestrutura de nuvem privada e pública (LEÃO et al., 2016). Isso ocorre porque a identificação corporativa, autenticação, gerenciamento de políticas e estruturas de governança podem não se estender naturalmente para a nuvem pública. As empresas gerenciam e interagem com os serviços em nuvem por meio de suas APIs, por isso é importante certificar-se de que essas interfaces sejam adequadamente projetado para proteger os dados contra quaisquer riscos, tanto acidentais quanto maliciosos (SERGIO, 2017).

É evidente que existem inúmeros riscos quando se trata de virtualização de servidores. O objetivo desta seção é mostrar ou evidenciar que na virtualização de servidores não existem “apenas vantagens”, ou seja, é preciso ter um controle aprimorado, saber o que esta fazendo para minimizar riscos. Pode-se listar vários outros riscos como:

- Dados confidenciais em uma VM.

- Segurança de VMs off-line e inativas.

- Segurança de VMs pré-configuradas (imagem dourada) / VMs ativas.

- Falta de visibilidade e controle sobre redes virtuais.

- Esgotamento de recursos.

- Segurança do hipervisor.

- Acesso não autorizado ao hipervisor.

- Cargas de trabalho de diferentes níveis de confiança localizadas no mesmo servidor.

Porém, todos os riscos podem ser minimizados com um controle eficiente, configurações de segurança adequadas, registros e logs de usuários da rede, entre outros. Afinal, dentro de Tecnologia da Informação, o requisito de “segurança”, sempre será visto como uma barreira a ser superada, independente do que estiver sendo realizado.

2.3 VIRTUALIZAÇÃO E A UTILIZAÇÃO DE CONTÊINERES

Os containers são uma forma de virtualização do sistema operacional (TRINDADE e COSTA, 2019). Um único container pode ser usado para executar qualquer coisa, desde um pequeno micro serviço ou processo de software até um aplicativo maior. Dentro de um container estão todos os executáveis, códigos binários, bibliotecas e arquivos de configuração necessários. Comparado às abordagens de virtualização de servidor ou máquina, no entanto, os containers não contêm imagens do sistema operacional.

Isso os torna mais leves e portáteis, com significativamente menos sobrecarga. Em implantações de aplicativos maiores, vários containers podem ser implantados como um ou mais clusters de contêineres. Esses clusters podem ser gerenciados por um orquestrador de containers como o Kubernetes (VARGHESE et al., 2016).

Os containers são uma maneira simplificada de criar, testar, implantar e reimplementar aplicativos em vários ambientes, desde o laptop local de um desenvolvedor até um data center local e até a nuvem (TRINDADE e COSTA, 2019).

Desta forma Varghese et al. (2016), destaca os benefícios dos containers que incluem:

Menos sobrecarga: Os containers exigem menos recursos do sistema do que os ambientes de máquinas virtuais tradicionais ou de hardware, porque não incluem imagens do sistema operacional.

Maior portabilidade: Os aplicativos em execução nos containers podem ser implantados facilmente em vários sistemas operacionais e plataformas de hardware.

Operação mais consistente: As equipes do DevOps sabem que os aplicativos em containers serão executados da mesma forma, independentemente de onde eles estão implantados.

Maior eficiência: Os containers permitem que os aplicativos sejam implantados, corrigidos ou dimensionados mais rapidamente.

Melhor desenvolvimento de aplicativos: Os containers suportam os esforços ágeis e do DevOps para acelerar os ciclos de desenvolvimento, teste e produção.

Pesic (2016), menciona com relação aos casos de uso de container, pode-se citar que as formas comuns pelas quais as organizações usam containers incluem:

“Levante e mude” os aplicativos existentes para as arquiteturas modernas de nuvem: Algumas organizações usam containers para migrar aplicativos existentes para ambientes mais modernos. Embora essa prática ofereça alguns dos benefícios básicos da virtualização do sistema operacional, ela não oferece todos os benefícios de uma arquitetura de aplicativos modular, baseada em contêiner.

Refatorar aplicativos existentes para contêineres: Embora a refatoração seja muito mais intensiva que a migração de elevação e troca, ela oferece todos os benefícios de um ambiente de contêiner.

Desenvolver novos aplicativos nativos de contêiner: Assim como a refatoração, essa abordagem libera todos os benefícios dos contêineres.

Fornecer melhor suporte para arquiteturas de micro serviços: Aplicativos e micro serviços distribuídos podem ser mais facilmente isolados, implantados e dimensionados usando blocos de construção de containers individuais.

Fornecer suporte ao DevOps para integração e implantação contínuas (CI / CD): A tecnologia de containers oferece suporte à criação, teste e implantação simplificados a partir das mesmas imagens de contêiner.

Fornecer uma implantação mais fácil de tarefas e trabalhos repetitivos: Os containers estão sendo implantados para oferecer suporte a um ou mais processos semelhantes, que geralmente são executados em segundo plano, como funções ETL ou tarefas em lote.

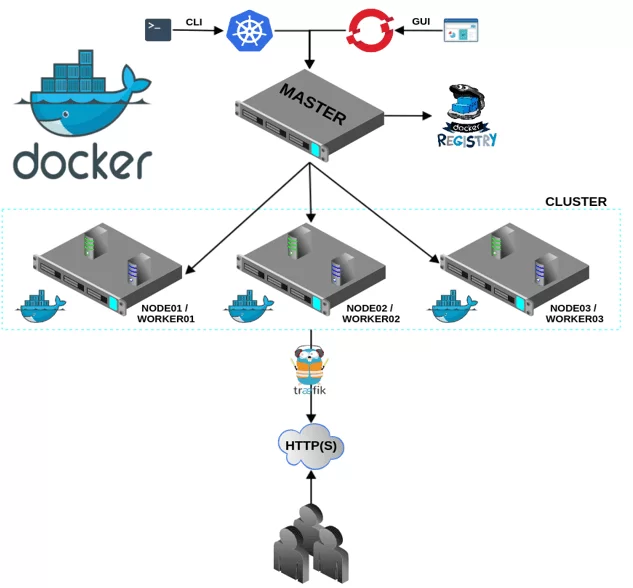

2.4 RELACIONAMENTOS ENTRE DOCKER, KUBERNETES COM CONTAINERS

Os usuários envolvidos em ambientes de container provavelmente ouvirão sobre duas ferramentas e plataformas populares usadas para criar e gerenciar containers. Estes são o Docker e o Kubernetes.

O Docker é um ambiente de tempo de execução popular usado para criar e criar software dentro de contêineres (SCHENKER, 2018). Ele usa imagens do Docker (instantâneos de cópia na gravação) para implantar aplicativos ou software em containers em vários ambientes, do desenvolvimento ao teste e produção.

O Docker foi desenvolvido com base em padrões e funções abertos nos ambientes operacionais mais comuns, incluindo Linux, Microsoft Windows e outras infraestruturas locais ou baseadas na nuvem (SCHENKER, 2018).

Figura 5 – Infraestrutura com orquestração de Containers

O Docker foi desenvolvido com base em padrões e funções abertos nos ambientes operacionais mais comuns, incluindo Linux, Microsoft Windows e outras infraestruturas locais ou baseadas na nuvem (VERTIGO, 2019).

Aplicativos em containers podem ficar complicados, no entanto, quando em produção, muitos podem exigir centenas a milhares de containers separados na produção. É aqui que os ambientes de tempo de execução do container, como o Docker, se beneficiam do uso de outras ferramentas para orquestrar ou gerenciar todos os containers em operação.

Uma das ferramentas mais populares para esse fim é o Kubernetes, um orquestrador de containers que reconhece vários ambientes de tempo de execução do contêiner, incluindo o Docker (SCHENKER, 2018).

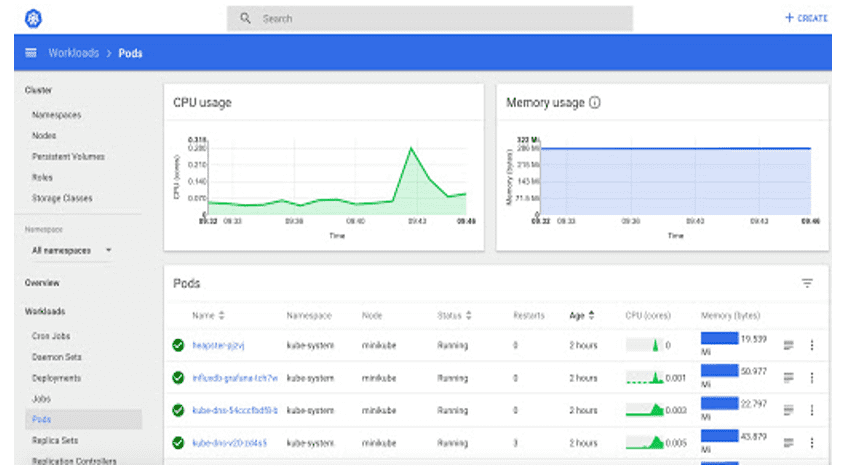

O Kubernetes orquestra a operação de vários containers em harmonia juntos. Ele gerencia áreas como o uso de recursos de infraestrutura subjacentes para aplicativos em container, como a quantidade de recursos de computação, rede e armazenamento necessários. Na Figura 6, é demonstrado uma ferramenta desenvolvida pelo Google, onde o mesmo utiliza para projetos organizacionais. Um destes projetos e o Cloud Native Computing Foundation,

Figura 6 – Ferramenta Kubernetes da Google – demonstração

Ferramentas de orquestração como o Kubernetes facilitam a automação e o dimensionamento de cargas de trabalho baseadas em container para ambientes de produção ao vivo.

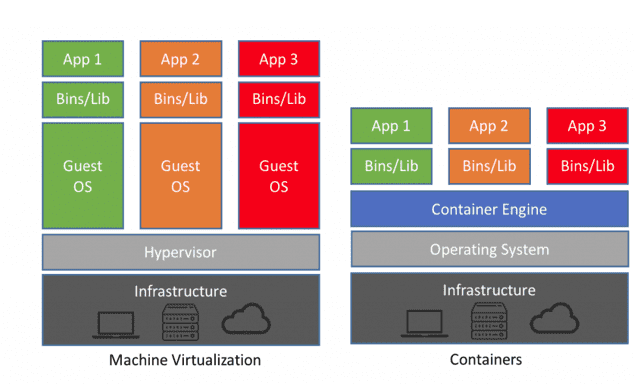

2.5 CONTAINERS X MAQUINAS VIRTUAIS (VMS)

Historicamente, à medida que o poder e a capacidade de processamento do servidor aumentavam, os aplicativos não eram capazes de explorar a nova abundância de recursos. Assim, nasceram as VMs, projetadas executando software em cima de servidores físicos para emular um sistema de hardware específico (TORRE, 2015).

Às vezes, as pessoas confundem a tecnologia de containers com máquinas virtuais (VMs) ou tecnologia de virtualização de servidores. Embora existam algumas semelhanças básicas, os containers são muito diferentes das VMs.

As máquinas virtuais são executadas em um ambiente de hipervisor, em que cada máquina virtual deve incluir seu próprio sistema operacional convidado, juntamente com os binários, bibliotecas e arquivos de aplicativos relacionados.

Isso consome uma grande quantidade de recursos e sobrecarga do sistema, especialmente quando várias VMs estão em execução no mesmo servidor físico, cada uma com seu próprio sistema operacional convidado. Por outro lado, cada container compartilha o mesmo sistema operacional host ou kernel do sistema e é muito mais leve, geralmente apenas megabytes.

Isso geralmente significa que um container pode levar apenas alguns segundos para iniciar (em comparação com os gigabytes e minutos necessários para uma VM típica). Um hipervisor ou monitor de máquina virtual é um software, firmware ou hardware que cria e executa VMs. É o que fica entre o hardware e a máquina virtual e é necessário virtualizar o servidor.

Dentro de cada máquina virtual, é executado um sistema operacional convidado exclusivo (MICROSOFT DOCS, 2019). VMs com sistemas operacionais diferentes podem ser executados no mesmo servidor físico – uma VM UNIX pode ficar ao lado de uma VM Linux, e assim por diante. Cada VM possui seus próprios binários, bibliotecas e aplicativos que atende, e a VM pode ter muitos gigabytes de tamanho.

Na Figura 7 abaixo e possível perceber o esquema da infraestrutura da Máquina Virtual x Containers, na concepção de (SCHENKER, 2018).

Figura 7 – Infraestrutura de MVr x Containers

A virtualização de servidores oferece vários benefícios, sendo um dos maiores a capacidade de consolidar aplicativos em um único sistema. A virtualização gera economia de custos por meio de área de ocupação reduzida, provisionamento mais rápido de servidores e recuperação de desastres (DR) aprimorada, porque o hardware do site de DR não precisava mais espelhar o data center principal.

O desenvolvimento também se beneficia dessa consolidação física, porque uma maior utilização em servidores maiores e mais rápidos libera servidores subsequentemente não utilizados para serem redirecionados para controle de qualidade, desenvolvimento ou equipamento de laboratório.

Mas essa abordagem tem suas desvantagens. Cada VM inclui uma imagem de sistema operacional separada, que adiciona sobrecarga na memória e na área de armazenamento. Como se vê na infraestrutura (Figura 7), esse problema adiciona complexidade a todos os estágios de um ciclo de vida de desenvolvimento de software – do desenvolvimento e teste à produção e recuperação de desastres. Essa abordagem também limita severamente a portabilidade de aplicativos entre nuvens públicas, nuvens privadas e data centers tradicionais.

2.6 DATA CENTER E SUAS EVOLUÇÕES

Os data centers estão no centro da moderna tecnologia de software, desempenhando um papel crítico na expansão dos recursos para as empresas (LIMA, 2009). Enquanto as empresas, há poucas décadas, se baseavam em métodos de documentação em papel e lápis com tendência a erros, os datacenters melhoraram bastante a usabilidade dos dados como um todo.

Eles permitiram que as empresas fizessem muito mais com muito menos, tanto em termos de espaço físico quanto do tempo necessário para criar e manter dados. Mas os data centers estão posicionados para desempenhar um papel ainda mais importante no avanço da tecnologia, com novos conceitos entrando no cenário que representam uma mudança drástica na maneira como os data centers são concebidos, configurados e utilizados.

O data center tradicional, também conhecido como data center “em silos”, depende muito de hardware e servidores físicos. É definido pela infraestrutura física, que é dedicada a uma finalidade específica e determina a quantidade de dados que podem ser armazenados e manipulados pelo data center como um todo (LIMA, 2009). Além disso, os datacenters tradicionais são restritos pelo tamanho do espaço físico no qual o hardware está armazenado (JUNIOR, 2015).

O armazenamento, que depende do espaço do servidor, não pode ser expandido além das limitações físicas do espaço. Mais armazenamento requer mais hardware e, ao preencher a mesma metragem quadrada com hardware adicional, será mais difícil manter o resfriamento adequado. Portanto, os data centers tradicionais estão fortemente vinculados a limitações físicas, tornando a expansão uma grande empresa (VERAS, 2010).

Os primeiros computadores eram muito semelhantes ao data center tradicional que conhecemos hoje. Os data centers isolados, como são usados hoje, explodiram durante a era das pontocom no final dos anos 90 e início dos anos 2000.

O rápido aumento no número de sites e aplicativos exigia armazenamento físico em algum lugar para abrigar as grandes quantidades de dados necessárias para que esses programas sejam executados sob demanda no navegador do usuário.

Os primeiros data centers ofereciam desempenho e confiabilidade suficientes, especialmente considerando que havia pouco ponto de referência. A entrega lenta e ineficiente foi um desafio importante e a utilização foi surpreendentemente baixa em relação à capacidade total de recursos. Pode levar meses para a empresa implantar novos aplicativos com um data center tradicional (SCHULS e SILVA, 2012).

Entre 2003 e 2010, os datacenters virtualizados surgiram quando a revolução da tecnologia virtual tornou possível reunir os recursos de computação, rede e armazenamento de vários datacenters anteriormente isolados para criar um recurso central e mais flexível que poderia ser realocado com base nas necessidades. Em 2011, cerca de 72% das organizações disseram que seus data centers eram pelo menos 25% virtuais.

Por trás do data center virtualizado, está a mesma infraestrutura física que compreendia um data center tradicional e isolado. A tecnologia de computação em nuvem que as empresas e os consumidores desfrutam é orientada pelas mesmas configurações que existiam antes da virtualização do servidor – mas com maior flexibilidade graças aos recursos agrupados.

Desta forma, as deficiências da virtualização de servidores revelam oportunidades ocultas, como a tecnologia está sempre avançando, o pool de recursos para criar pools maiores, mais flexíveis e centralizados de recursos de computação, armazenamento e rede não representa bem utopia em termos de design de data center. Os silos individuais – conhecidos como farms de servidores – sendo agrupados ainda devem ser mantidos e gerenciados separadamente.

Um grande desafio da TI atualmente é que as organizações podem gastar facilmente de 70 a 80% de seus orçamentos em operações, incluindo a otimização, manutenção e manipulação do ambiente. A virtualização de servidores ofereceu o benefício de uma melhor utilização dos ciclos de computação, mas na verdade teve impactos negativos nos componentes de armazenamento e rede (SCHULS e SILVA, 2012).

Existem duas opções principais: simplificar o ambiente, por meio de uma infraestrutura convergente ou movendo-se para um data center pronto ou terceirizar todo ou parte do ambiente para um provedor de nuvem de terceiros que, então, assumirá parte ou todo o conjunto a carga de manutenção. Para TI, a virtualização de servidores não era a resposta, mas um trampolim para a solução definitiva (VERAS, 2010).

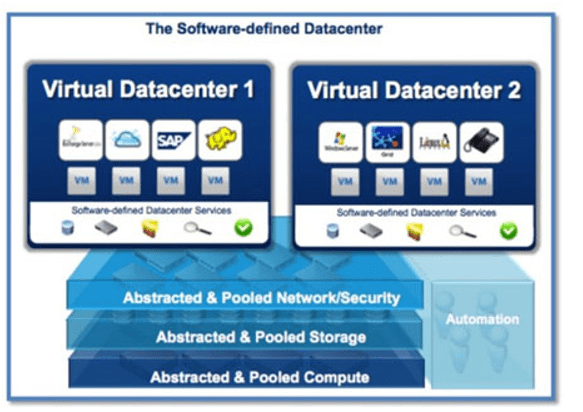

2.7 PROVENDO ESTRUTURAS LIDERADAS POR SOFTWARE

A virtualização de servidores forneceu uma amostra do que seria finalmente possível. Melhor utilização é obtida quando as cargas de trabalho do aplicativo estão nos níveis ideais. Porém, como um pool de recursos compartilhados, um aumento repentino e inesperado na utilização de um aplicativo significa uma escassez de recursos disponíveis para o restante dos aplicativos, contando com os mesmos recursos (BENEDETE, 2007).

Isso significa que os sistemas operacionais convidados, ou os que não são nativos do datacenter, podem sofrer uma escassez de recursos de computação. Quando isso ocorre, os acordos de nível de serviço, que normalmente garantem uptime do servidor de quase 100% e garantem a disponibilidade de recursos, foram basicamente quebrados.

O controle programático da alocação de recursos para aplicativos deixou claro que os recursos de computação e servidor se beneficiam do aumento da utilização no ambiente do datacenter, mas não é suficiente para lidar com as cargas de trabalho dinâmicas das empresas de hoje (BIEBERSTEIN, 2006).

A maioria dos centros de dados atende a uma combinação de aplicativos intensivos em computação e aplicativos mais simples que lidam com tarefas importantes, mas menos exigentes, associadas à administração de uma empresa.

Figura 8 – Data Center definido por Software

Desta forma, subtende-se que o melhor da virtualização e automação, entre na infraestrutura liderada por software (SLI), que visa capitalizar a tecnologia de virtualização para aproveitar todos os benefícios do data center virtual, permitindo portabilidade, funcionalidade, armazenamento e automação de aplicativos dentro e entre os data centers (BIEBERSTEIN, 2006).

A principal característica definidora do SLI é que o controle total é exercido pelo software. Isso inclui automatizar o controle da implantação, provisionamento, configuração e operação com software, criando um hub centralizado para monitorar e gerenciar uma rede de data centers.

O software também exerce controle automatizado sobre os componentes físicos e de hardware do data center, incluindo a automação de recursos de energia e a infraestrutura de refrigeração, além da infraestrutura de rede.

Sem esses componentes vitais, um data center não funcionaria – e, em vez de falhar em um aplicativo devido à escassez de recursos de computação, todos os aplicativos que dependem do data center não funcionariam. O SLI é capaz de suportar as cargas de trabalho dinâmicas de hoje, acoplando a automação à elasticidade da nuvem, o que pode reduzir ou expandir sua capacidade com base nas demandas da carga de trabalho atual (NATIS, 2007).

Lidar com cargas de trabalho dinâmicas com alocação automatizada de recursos e aliviar os encargos de TI com controle automatizado sobre infraestruturas físicas e de rede não são os únicos recursos do SLI, também conhecido como data center definido por software (SDDC), um termo cunhado pelo ex-CTO da VMware, Dr. Steve Herrod (2012). O SLI é capaz de suportar aplicativos corporativos legados, bem como serviços de computação em nuvem.

Atualmente, existem mais cargas de trabalho virtuais do que físicas implantadas no cenário de negócios. Essas cargas de trabalho exigem uma quantidade correlacional de recursos, o que criaria uma carga significativa para a TI ao contar com os data centers tradicionais.

Mas o SLI torna os recursos mais fluidos e adaptáveis, para que possam ser realocados e compartilhados com mais facilidade, não apenas por aplicativos que compartilham os recursos de um único data center, mas mesmo entre data centers.

Isso significa que os recursos podem ser realocados para diferentes unidades de negócios de maneira transparente e conforme necessário para atender às necessidades gerais da organização. E com esse modelo, os componentes de serviço passam de silos distintos para pares eficientes e colaborativos.

2.8 O FUTURO DOS DATA CENTERS

O SLI ainda está engatinhando, mas é considerado o próximo passo na evolução de data centers, virtualização e computação em nuvem. A combinação de virtualização de servidores, redes definidas por software (SDN), armazenamento definido por software (SDS) e automação permitirá a criação de um data center virtualizado verdadeiramente dinâmico (CISCO, 2014).

SDN e SDS ainda são novas tecnologias que ainda não foram firmemente estabelecidas no cenário dos datacenters, mas terão um lugar na visão definitiva do SLI totalmente automatizado e dinâmico. Menciona-se também a nova categoria da Wikibon – Server SAN – que é uma arquitetura de computação e armazenamento convergente altamente escalonáveis.

Mais importante, este novo modelo não se encaixa na equação tradicional de mais recursos que exigem mais recursos – recursos físicos, tempo, recursos financeiros e muito mais. Em vez disso, o SLI aprimora a funcionalidade e a eficiência, reduzindo a carga de TI e operacional por meio da automação (EMC, 2009).

Sobre a transição para SLI, denota-se que a TI deve encontrar maneiras mais eficientes de fornecer serviços. O SLI facilita a transição da TI como um centro de custo para a TI como uma faceta que impulsiona o crescimento dos negócios.

Uma agilidade mais ampla, mais flexibilidade e uma resposta imediata aos requisitos de negócios permitem um alinhamento próximo entre as metas de TI e de negócios – que tradicionalmente podem ser drasticamente diferentes (FALCCIONE FILHO, 2016)..

Já sobre os benefícios do SLI, nota-se que ao criar um tempo de provisionamento significativamente menor, reduzindo o período típico de semanas ou meses a meros minutos. Também elimina completamente os silos de negócios, o que significa maior visibilidade em toda a organização e maior conscientização de outras áreas e requisitos (FALCCIONE FILHO, 2016).

Com automação completa e um único ponto de controle centralizado, o SLI resulta em uma utilização de recursos drasticamente aprimorada. No data center tradicional, ou na infraestrutura herdada, a utilização de recursos atinge cerca de 30%. Isso foi levemente aprimorado com o data center virtual, permitindo a utilização de recursos em cerca de 50%. O SLI aumentará isso significativamente com uma utilização de recursos de até 70%, muito mais eficiente que os modelos anteriores (ROSARIO, 2016).

Pode parecer que o objetivo final é que os data centers existam exclusivamente na nuvem, sem exigir nenhuma infraestrutura física. Além de ser uma impossibilidade prática, não é realmente uma solução desejável. Atualmente, a maioria das empresas possui pelo menos alguns dados que nunca devem ser armazenados fora do local.

É exatamente por isso que a maioria das empresas atualmente usa uma mistura de serviços e armazenamento de dados na nuvem e no local. As empresas estão cada vez mais confiando nos serviços oferecidos via nuvem. E à medida que mais serviços em nuvem se tornam disponíveis, as empresas estão transferindo mais processos para a nuvem, como e-mail, mensagens instantâneas e aplicativos em nuvem de suítes de escritório, como o Google Apps.

Os centros de dados futuros terão, no entanto, uma presença física muito menor à medida que mais componentes do centro de dados forem virtualizados. Um conjunto menor de hardware básico pode conter centenas a milhares de servidores e máquinas virtuais, criando recursos praticamente ilimitados com pool e automação de recursos (ROSARIO, 2016).

3. CONCLUSÃO

A virtualização se tornou um foco extremamente importante do mundo da TI nos últimos anos. As tecnologias de virtualização são usadas por incontáveis milhares de empresas para consolidar suas cargas de trabalho e tornar seus ambientes de TI escaláveis e mais flexíveis. Foi percebido ao longo dos estudos deste artigo, que a virtualização pode aumentar a agilidade, flexibilidade e escalabilidade de TI, criando economias de custo significativas. Maior mobilidade da carga de trabalho, maior desempenho e disponibilidade de recursos, operações automatizadas – todos são benefícios da virtualização que tornam a TI mais simples de gerenciar e menos dispendiosa de possuir e operar.

Além disso, percebe-se que existem benefícios adicionais como os custos operacionais e de capital reduzidos, o tempo de inatividade minimizado ou eliminado, o aumento da produtividade, eficiência, agilidade e capacidade de resposta de TI, além do provisionamento mais rápido de aplicativos e recursos, uma maior continuidade de negócios e recuperação de desastres.

Devido às limitações dos servidores x86, muitas organizações de TI devem implantar vários servidores, cada um operando com uma fração de sua capacidade, para acompanhar as altas demandas de armazenamento e processamento de hoje. O resultado: enormes ineficiências e custos operacionais excessivos.

A virtualização depende de software para simular a funcionalidade do hardware e criar um sistema de computador virtual. Isso permite que as organizações de TI executem mais de um sistema virtual – e vários sistemas operacionais e aplicativos – em um único servidor. Os benefícios resultantes incluem economias de escala e maior eficiência.

Embora tecnologias igualmente valiosas, virtualização e computação em nuvem não são intercambiáveis. A virtualização é um software que torna os ambientes de computação independentes da infraestrutura física, enquanto a computação em nuvem é um serviço que entrega recursos de computação compartilhados (software e / ou dados) sob demanda pela Internet. Como soluções complementares, as organizações podem começar virtualizando seus servidores e, em seguida, migrar para a computação em nuvem para obter ainda mais agilidade e autoatendimento.

REFERÊNCIAS

4LINUX (2019). Containers com Docker, Kubernetes e Openshift. Disponível em: https://www.4linux.com.br/suporte/consultoria-containers-docker-kubernetes-openshift Acesso em: 15 set. 2020.

BACELAR, E. et. al. (2012) O modelo de computação em nuvem e suas aplicabilidades. Disponível em: http://repositorio.furg.br/bitstream/handle/1/4947/Modelo%20de%20Computa%C3%A7%C3%A3o%20em%20Nuvem%20e%20sua%20Aplicabilidade..pdf?sequence=1 Acesso em: 11 ago. 2020.

BENEDETE, Antonio Carlos Junior. Roteiro para a definição de uma arquitetura SOA utilizando BPM. Escola Politécnica da Universidade de São Paulo. 2007. Disponível em: file:///C:/Users/wesle/AppData/Local/Temp/RoteiroSOA-BPM-1.pdf Acesso em: 21 set 2020.

BIEBERSTEIN, N. et al. Service Oriented Architecture (SOA) Compass. NJ, EUA:IBM, 2006.

CHOINACKI, Hugo. Virtualização de Servidores. Universidade Tecnológica Federal Do Paraná – Departamento Acadêmico De Eletrônica curso De Especialização Em Gerenciamento De Servidores E Equipamentos De Redes. 2016. Disponível em: http://repositorio.roca.utfpr.edu.br/jspui/bitstream/1/1836/1/CT_GESER_II_2012_14.pdf Acesso em: 11 ago. 2020.

CISCO (2014). Evolução da rede de data center: prepare-se para aumentar o valor comercial. Disponível em: https://www.cisco.com/c/dam/global/pt_br/assets/pdfs/FY14-DC-02_ntwk-evol-whitepaper_cte_wp_etmg_pt-br_35119.pdf Acesso em: 21 set 2020.

CSA (2015) – Best Practices for Mitigating Risks in Virtualized Environments. Disponível em: https://downloads.cloudsecurityalliance.org/whitepapers/Best_Practices_for%20_Mitigating_Risks_Virtual_Environments_April2015_4-1-15_GLM5.pdf Acesso em: 19 ago. 2020.

EMC, Fórum. Data Center de última geração, 2009. Disponível em: https://brazil.emc.com/collateral/microsites/2009/forum/robin-tate-data-center.pdf Acesso em 21 set 2020

FACCIONIFILHO, Mauro. Conceitos e infraestrutura de datacenters: livro digital. Palhoça: Unisul Virtual, 2016.

INFOSEC (2018). 11 Points to Consider When Virtualizing Security. Disponível em: https://resources.infosecinstitute.com/11-points-consider-virtualizing-security/#gref Acesso em: 19 ago. 2020.

JUNIOR, Juarez Santana Fracalossi. Eficiência Energética Em Data Center: Estudo De Caso UNIVATES Centro Universitário UNIVATES – 2015. Disponível em: https://www.univates.br/bdu/bitstream/10737/984/1/2015JuarezSantanaFracalossiJunior.pdf Acesso em: 21 set 2020.

KASPERSKY (2014) – Global it security risks survey 2014 – virtualization. Kasperskey Lab, 2014. Disponível em: https://media.kaspersky.com/en/IT_Security_Risks_Survey_2014_Virtualization_report.pdf?_ga=1.266853710.1550408904.1406566666 Acesso em: 19 ago 2020.

LEÃO CARNEIRO, João Bosco; MELO, Daniel Reis Armond de. Análise da tecnologia de virtualização de servidores em um data center como fator para obtenção de ganhos de produtividade. Revista Espacios. v. 37, nº 27.2016.p. 20-32.

LIMA, Cristiano & de MELO Costa, Danilo & SILVA, Cláudio. (2012). Virtualização de servidores: um estudo de caso na empresa sênior engenharia. Revista Pensar Tecnologia. 3. 1. Disponível em: https://www.researchgate.net/publication/326722928_VIRTUALIZACAO_DE_SERVIDORES_UM_ESTUDO_DE_CASO_NA_EMPRESA_SENIOR_ENGENHARIA Acesso em: 11 ago. 2020.

LIMA, Marcio A. S. Uma Infraestrutura de Comando e Controle de Data Center para um Conjunto de Recursos Computacionais. Escola Politécnica da Universidade de São Paulo – 2009. Disponível em: https://www.teses.usp.br/teses/disponiveis/3/3141/tde-01092009-151011/publico/Tese_Marcio_A_L_Silva_NUSP1612085_FINAL.pdf Acesso em: 21 set 2020.

MICROSOFT DOCS (2019). Containers x Máquinas Virtuais. Disponível em: https://docs.microsoft.com/pt-br/virtualization/windowscontainers/about/containers-vs-vm Acesso em: 15 set. 2020.

NATIS, Y. Predicts 2007: SOA Advances. EUA: Gartner, id: G00144445, Novembro de 2007

PAIVA, Danilo A. Virtualização da infraestrutura: sistematização e pesquisas correntes. 2019. Departamento de Ciência da Computação do Instituto de Ciências Exatas da Universidade Federal de Minas Gerais. Disponível em: https://repositorio.ufmg.br/bitstream/1843/32268/1/TCC%20-%20MONOGRAFIA%20-%20DANILO%20ALMEIDA%20PAIVA.pdf Acesso em: 19 ago. 2020.

RECOVERY, Assured. Tendências de virtualização de servidores. Copyright © 2016 Arcserve (USA), LLC e suas afiliadas e subsidiárias. Disponível em: https://arcservelatam.com/virtual-world/docs/port/virtualization-ebook-por.pdf Acesso em: 11 ago. 2020.

ROSÁRIO, Djan de Almeida do. Disponibilidade e qualidade operacional de data centers. 70p. Palhoça: Unisul Virtual, 2016.

SCHENKER, Dr. Gabriel N. Containerize your Apps with Docker and Kubernetes. 2018. Disponível em: https://info.microsoft.com/rs/157-GQE-382/images/EN-CNTNT-Containerize%20apps%20with%20docker%20and%20kubernetes%20preview-en-us.pdf Acesso em: 15 set. 2020

SCHULS, M. A., SILVA T. N., Ti Verde e Eficiência Energética em Data Center, Revista de Gestão Social e Ambiental -RGSA, São Paulo, v. 6, n. 1, p. 121-133, maio/ago. 2012

SÉRGIO, Leandro. Contêineres ou máquinas virtuais, qual é o melhor método para virtualização? Computer world. 2017 – Disponível em: https://computerworld.com.br/2017/11/27/conteineres-ou-maquinas-virtuais-qual-e-o-melhor-metodo-para-virtualizacao/. Acesso em 19 ago. 2020.

TAURION, C. Cloud Computing: Computação em Nuvem: Transformando o Mundo da Tecnologia da Informação. São Paulo: Brasport, 2009.

TORRE, María Cabrera Gómez de la. Gestión Decontenedores docker -Kubernetes. 2015. Disponível em: http://informatica.gonzalonazareno.org/proyectos/2015-16/proyectoDK.pdf Acesso em: 15 set. 2020

TRINDADE, Leon Valentim Porto, COSTA, Luís Henrique M. K. Análise do Desempenho da Virtualização Leve para Ambientes com Edge Computing baseada em NFV. Universidade Federal do Rio de Janeiro – 2019. Disponível em: Acesso em: https://www.gta.ufrj.br/ftp/gta/TechReports/TrCo18.pdf 15 set. 2020.

VARGHESE, B., SUBBA, L. T., THAI, L., e BARKER, A. (2016). Container-Based Cloud Virtual Machine Benchmarking. Páginas 192–201. IEEE.

VERAS M. Datacenters: Componente Central da Infraestrutura de TI. 1 ed. Rio de Janeiro: Brasport, 2010

VERTIGO (2019). Ferramentas de orquestração de containers: como escolher? Disponível em: https://vertigo.com.br/ferramentas-de-orquestracao-de-containers/ Acesso em: 15 set. 2020.

WIKIBON (2019) – Disponível em: http://wikibon.org/w/images/2/2a/Virtual-datacenter_616.jpg. Acesso em: 21 set 2020.

[1] Bacharel em Sistemas de Informação.

Enviado: Janeiro, 2021.

Aprovado: Fevereiro, 2021.